KDD'24大廠推薦系統優化工作總結

今天這篇文章給大家介紹幾篇KDD2024中,大廠在推薦系統領域的優化工作,論文來自愛彼迎、騰訊、快手、美團等公司,設計多目標建模、多樣性、搜索意圖建模、ranking loss等問題。

1.愛彼迎:多目標建模和模型蒸餾

論文標題:Multi-objective Learning to Rank by Model Distillation

下載地址:https://arxiv.org/pdf/2407.07181

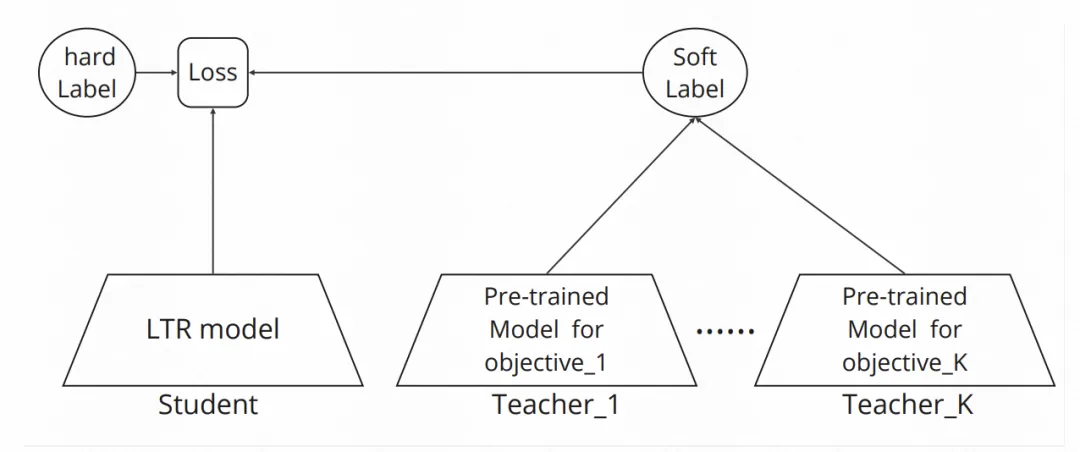

多目標建模轉換成模型蒸餾問題。多目標的場景要求最小化一個目標的預測誤差,同時其他目標的預估誤差在一個約束內。假設單獨訓練的一個單目標模型,效果一定比多目標一起訓練的這個目標的預測誤差要小,上述問題就等價于一個模型蒸餾損失函數。這個損失函數一方面包括主目標的hard label的優化目標,另一方面包括每個其他目標下,多目標蒸餾單目標最優模型soft label的優化目標。通過各個輔助目標蒸餾損失的權重,以及主目標hard label和輔助目標soft label的權重,調節模型優化過程。

2.Ranking Loss有效性分析

論文標題:Understanding the Ranking Loss for Recommendation with Sparse User Feedback

下載地址:https://arxiv.org/pdf/2403.14144

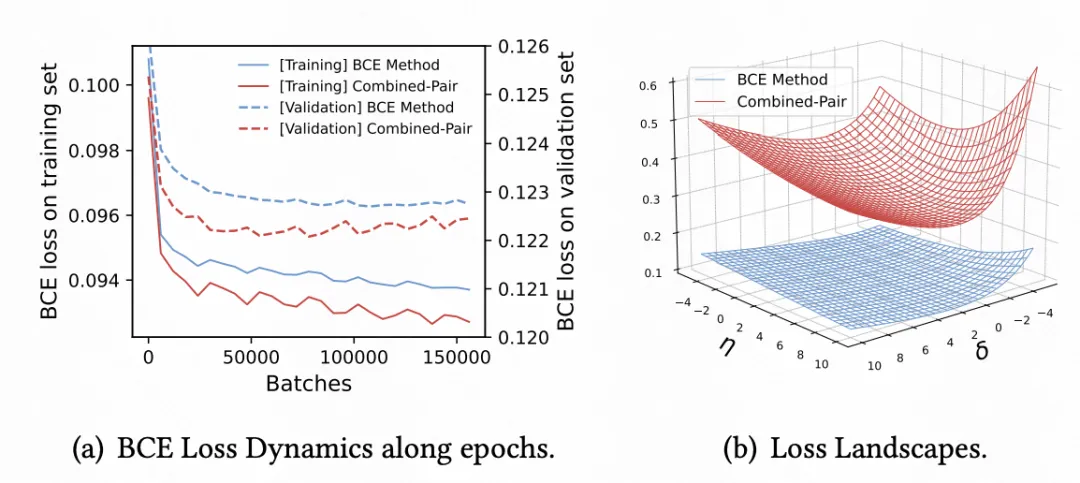

推薦系統的預估模型一般采用Binary Cross Entropy訓練,一些研究發現引入list-wise或者pair-wise的ranking loss可以顯著提升模型AUC。本文探索了ranking loss的引入帶來效果提升的原因。通過對比在BCE基礎上是否引入ranking loss,模型在梯度更新、訓練超平面等角度的分析,本文發現ranking loss有效的核心原因是在正樣本稀疏的場景下,相比單獨BCE模型,引入ranking loss可以讓梯度變得更大,模型訓練更容易收斂,負樣本優化超平面更加陡峭,進而帶來效果提升。

3.快手:上下文蒸餾提升精排多樣性

論文標題:Contextual Distillation Model for Diversified Recommendation

下載地址:??https://arxiv.org/pdf/2406.09021??

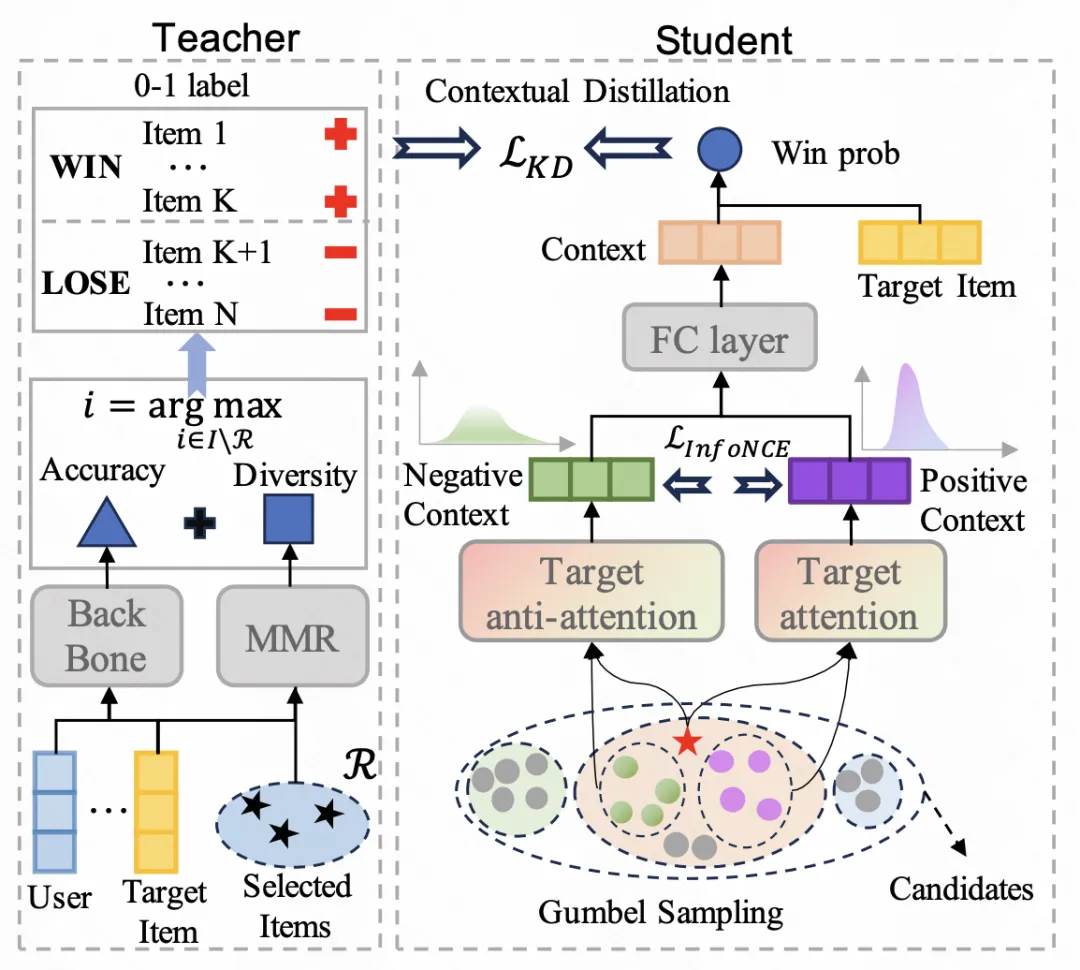

本文提出了一種在精排階段提升推薦系統多樣性的建模方法。一般提升推薦系統多樣性都是在重排階段使用NMR算法實現,該算法每次將精排打分最高且和已經選擇的候選相似度最低的樣本加入結果集,迭代該過程實現考慮推薦結果多樣性的重排。然而,如果精排階段沒有較好的考慮多樣性,會導致送入重排階段的多樣性較差,進而影響了整體推薦系統的多樣性。

為了解決上述問題,本文提出了一種基于上下文信息的多樣性蒸餾方法。該方法在精排模型中,以NMR的排序結果作為Teacher,將多樣性信息蒸餾到精排模型中。由于NMR算法需要輸入上下文信息,文中將所有精排候選當做上下文。同時,根據attention和anti-attention,從精排候選中采樣和當前item相關及對抗的候選,豐富上下文信息,并通過對比學習獲取兩類item的embedding,輸入MLP網絡蒸餾NMR Teacher的多樣性預測結果。

4.美團:搜索意圖引入推薦模型

論文標題:Unified Dual-Intent Translation for Joint Modeling of Search and Recommendation

下載地址:https://arxiv.org/pdf/2407.00912v1

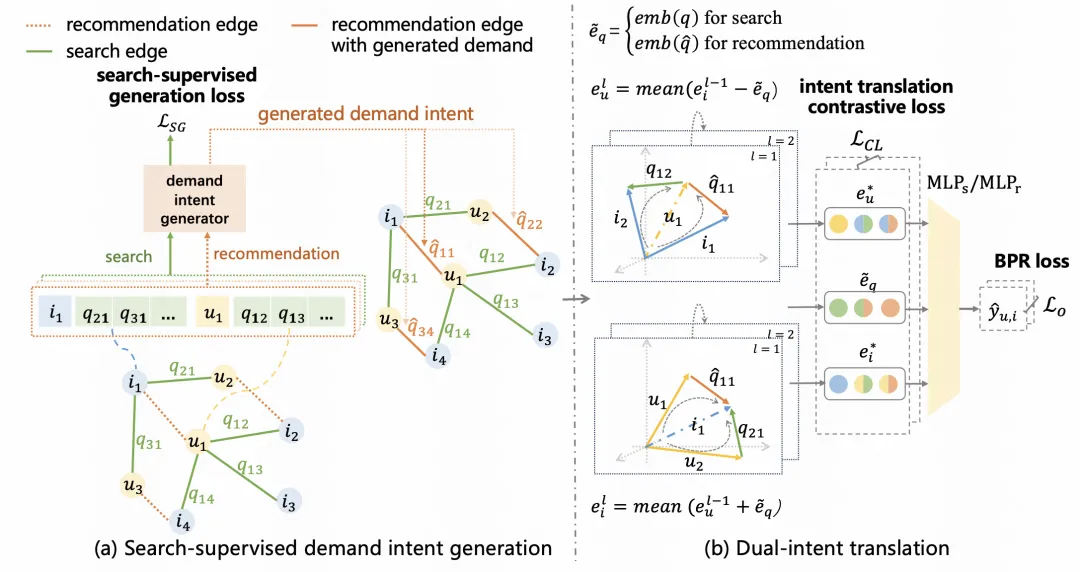

推薦系統相比搜索場景,一個核心難點是缺少像query那樣的顯示用戶意圖表達。本文提出利用搜索場景的用戶、item歷史搜索query,建模用戶的query意圖表征,相當于學習一個虛擬的用戶query,再將其表征應用到推薦系統中,提升推薦系統建模效果。

用戶意圖可以分為穩定意圖和變化意圖。針對這兩類意圖信息,文中構建了一個dual-intent轉化表征學習方法。首先基于用戶的歷史搜索query和點擊的item,構建異構圖,圖中節點是user或item,邊是用戶和item交互時搜索的query。對于query和user使用term embedding pooling以及引入user個性化門控等方式獲取query表征,并以用戶真實搜索query的表征作為進行監督學習,以此作為用戶的動態意圖。同時,使用GNN融合圖上用戶的臨接節點信息,刻畫用戶的固有意圖。最后,結合用戶交互item=用戶靜態意圖+動態意圖的轉化邏輯,建立表征優化的訓練目標。這些搜索意圖表征信息最后輸入到推薦系統模型底層進行最終目標擬合。

本文轉載自 ??圓圓的算法筆記??,作者: Fareise