斯坦福大學(xué)研究團(tuán)隊(duì)破解小規(guī)模語(yǔ)料庫(kù)知識(shí)獲取難題,提出創(chuàng)新的合成持續(xù)預(yù)訓(xùn)練方法

引言:探索小規(guī)模語(yǔ)料庫(kù)中的知識(shí)獲取

在現(xiàn)代的自然語(yǔ)言處理領(lǐng)域,大規(guī)模預(yù)訓(xùn)練模型已經(jīng)顯示出了在各種知識(shí)密集型任務(wù)中的卓越性能。這些模型通常依賴于大量的、結(jié)構(gòu)化不強(qiáng)的互聯(lián)網(wǎng)文本數(shù)據(jù)進(jìn)行訓(xùn)練,從而獲取豐富的世界知識(shí)。然而,這種知識(shí)獲取方式存在一個(gè)明顯的問(wèn)題:數(shù)據(jù)效率低下。為了學(xué)習(xí)特定的事實(shí),模型必須在成百上千的不同表述中進(jìn)行訓(xùn)練,這在面對(duì)小規(guī)模、特定領(lǐng)域的語(yǔ)料庫(kù)時(shí)尤為突出,因?yàn)樵谶@些語(yǔ)料庫(kù)中,每個(gè)事實(shí)可能很少出現(xiàn)或僅出現(xiàn)一次。

為了解決這一問(wèn)題,本文提出了一種新的方法——合成持續(xù)預(yù)訓(xùn)練(synthetic continued pretraining)。這種方法首先利用小規(guī)模的特定領(lǐng)域語(yǔ)料庫(kù)合成一個(gè)更易于學(xué)習(xí)的大規(guī)模語(yǔ)料庫(kù),然后在此合成語(yǔ)料庫(kù)上繼續(xù)進(jìn)行預(yù)訓(xùn)練。通過(guò)這種方式,模型能夠在沒(méi)有訪問(wèn)源文檔的情況下回答問(wèn)題和遵循與源文檔相關(guān)的指令。

本研究的核心貢獻(xiàn)包括提出了一種新的從小規(guī)模語(yǔ)料庫(kù)中獲取知識(shí)的方法,并通過(guò)實(shí)驗(yàn)驗(yàn)證了該方法的有效性。此外,本文還構(gòu)建了一個(gè)簡(jiǎn)單的數(shù)學(xué)模型來(lái)分析合成數(shù)據(jù)增強(qiáng)算法,并展示了如何通過(guò)合成數(shù)據(jù)增強(qiáng)來(lái)“重新排列”知識(shí),以實(shí)現(xiàn)更高效的學(xué)習(xí)。

論文標(biāo)題: Synthetic Continued Pretraining

機(jī)構(gòu): Stanford University

論文鏈接:??https://arxiv.org/pdf/2409.07431.pdf??

研究背景與動(dòng)機(jī)

在自然語(yǔ)言處理領(lǐng)域,大規(guī)模預(yù)訓(xùn)練模型已經(jīng)顯示出了在獲取世界知識(shí)方面的顯著能力,這使得它們能夠執(zhí)行知識(shí)密集型任務(wù)。然而,這種知識(shí)獲取過(guò)程是數(shù)據(jù)低效的,模型需要在成百上千的不同表達(dá)中學(xué)習(xí)到特定的事實(shí)。這在適應(yīng)特定領(lǐng)域的小規(guī)模文檔集時(shí)尤為挑戰(zhàn),因?yàn)樵谶@些文檔中,某些事實(shí)可能很少出現(xiàn)或只出現(xiàn)一次。

為了解決從小規(guī)模語(yǔ)料庫(kù)中獲取知識(shí)的問(wèn)題,我們提出了一種使用合成數(shù)據(jù)繼續(xù)預(yù)訓(xùn)練的方法。這種方法首先使用小規(guī)模的領(lǐng)域特定語(yǔ)料庫(kù)來(lái)合成一個(gè)更適合學(xué)習(xí)的大規(guī)模語(yǔ)料庫(kù),然后在這個(gè)合成的語(yǔ)料庫(kù)上進(jìn)行繼續(xù)預(yù)訓(xùn)練。這種方法的核心在于,通過(guò)合成數(shù)據(jù)增強(qiáng)算法來(lái)增加數(shù)據(jù)的多樣性,從而提高模型的數(shù)據(jù)效率和學(xué)習(xí)能力。

方法介紹:EntiGraph合成數(shù)據(jù)增強(qiáng)算法

1. 算法概述

EntiGraph是一種基于實(shí)體的數(shù)據(jù)增強(qiáng)算法,它通過(guò)分析文檔中的實(shí)體及其關(guān)系來(lái)合成新的文本數(shù)據(jù)。該算法首先從源文檔中提取關(guān)鍵實(shí)體,然后利用語(yǔ)言模型生成關(guān)于這些實(shí)體之間關(guān)系的文本描述,通過(guò)這種方式迭代地填充知識(shí)圖譜。

2. 實(shí)體提取

EntiGraph首先對(duì)文檔進(jìn)行實(shí)體提取,識(shí)別出文檔中的關(guān)鍵實(shí)體,如人名、地點(diǎn)、概念等。這一步是通過(guò)向預(yù)訓(xùn)練的語(yǔ)言模型輸入文檔并請(qǐng)求它標(biāo)識(shí)出文檔中的主要實(shí)體來(lái)完成的。

3. 實(shí)體描述生成

對(duì)于每個(gè)提取出的實(shí)體,EntiGraph使用語(yǔ)言模型生成該實(shí)體在文檔上下文中的詳細(xì)描述。這包括實(shí)體的定義、它在文檔中的作用以及與其他實(shí)體的關(guān)系等。

4. 關(guān)系分析

在實(shí)體描述生成之后,EntiGraph進(jìn)一步分析不同實(shí)體之間的關(guān)系。算法會(huì)探索實(shí)體對(duì)或?qū)嶓w組合之間的潛在聯(lián)系,并生成描述這些關(guān)系的文本。這一步驟幫助模型理解和學(xué)習(xí)實(shí)體之間復(fù)雜的相互作用和依賴。

通過(guò)這三個(gè)步驟,EntiGraph能夠從一個(gè)小規(guī)模的、信息密度高的語(yǔ)料庫(kù)中生成一個(gè)大規(guī)模的、信息豐富且多樣化的合成語(yǔ)料庫(kù),為語(yǔ)言模型的繼續(xù)預(yù)訓(xùn)練提供了更豐富的訓(xùn)練材料。這種方法不僅增強(qiáng)了模型對(duì)特定領(lǐng)域知識(shí)的理解,還提高了模型在面對(duì)新領(lǐng)域或少見(jiàn)事實(shí)時(shí)的適應(yīng)能力和表現(xiàn)。

實(shí)驗(yàn)設(shè)置

在本研究中,我們提出了一種名為“合成持續(xù)預(yù)訓(xùn)練”(synthetic continued pretraining)的方法,旨在通過(guò)合成數(shù)據(jù)增強(qiáng)來(lái)提高語(yǔ)言模型從小規(guī)模語(yǔ)料庫(kù)中學(xué)習(xí)的效率。我們使用了一個(gè)名為EntiGraph的數(shù)據(jù)增強(qiáng)算法,該算法通過(guò)分析和合成文檔中的實(shí)體關(guān)系來(lái)生成新的文本數(shù)據(jù)。

實(shí)驗(yàn)設(shè)計(jì)與評(píng)估方法

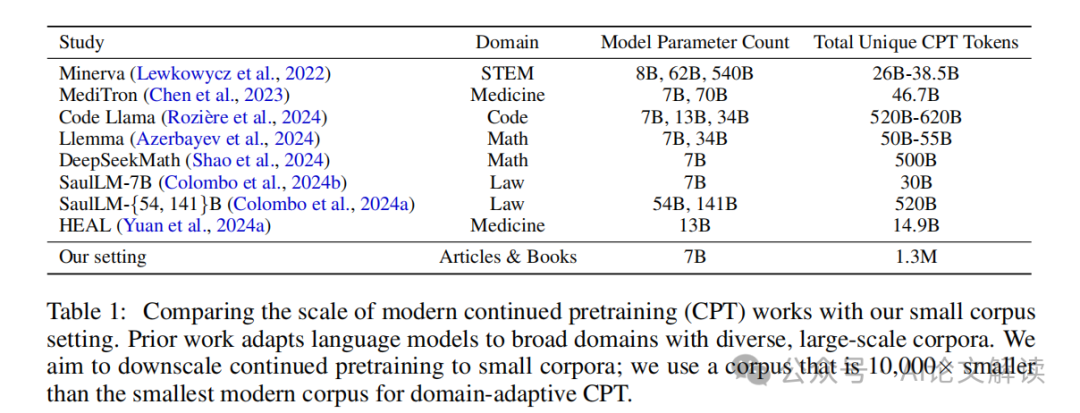

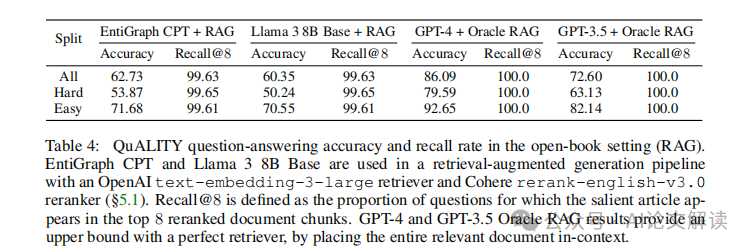

我們的實(shí)驗(yàn)基于標(biāo)準(zhǔn)的閱讀理解數(shù)據(jù)集(QuALITY, Pang et al. (2022))。在這個(gè)設(shè)置中,我們首先從一個(gè)包含265本書(shū)籍的小規(guī)模語(yǔ)料庫(kù)(總共1.3M個(gè)token)中,使用EntiGraph生成了600M個(gè)合成token。接著,我們?cè)谶@些合成token上繼續(xù)預(yù)訓(xùn)練一個(gè)名為L(zhǎng)lama 3 8B的語(yǔ)言模型,并在QuALITY問(wèn)題集上評(píng)估模型的問(wèn)答準(zhǔn)確性。

數(shù)據(jù)增強(qiáng)算法:EntiGraph

EntiGraph算法首先從源文檔中提取關(guān)鍵實(shí)體,然后利用語(yǔ)言模型生成關(guān)于這些實(shí)體的文本描述,以及這些實(shí)體之間的關(guān)系描述。這一過(guò)程包括三個(gè)步驟:

- 實(shí)體提取:從文檔中識(shí)別出關(guān)鍵實(shí)體。

- 單實(shí)體描述:為每個(gè)實(shí)體生成詳細(xì)的文本描述。

- 關(guān)系分析:生成描述實(shí)體間相互關(guān)系的文本。

通過(guò)這種方法,我們能夠從一個(gè)高度濃縮的知識(shí)表示中生成一個(gè)大規(guī)模、多樣化的合成語(yǔ)料庫(kù),為模型提供更豐富的學(xué)習(xí)材料。

主要實(shí)驗(yàn)結(jié)果與分析

問(wèn)答準(zhǔn)確性評(píng)估

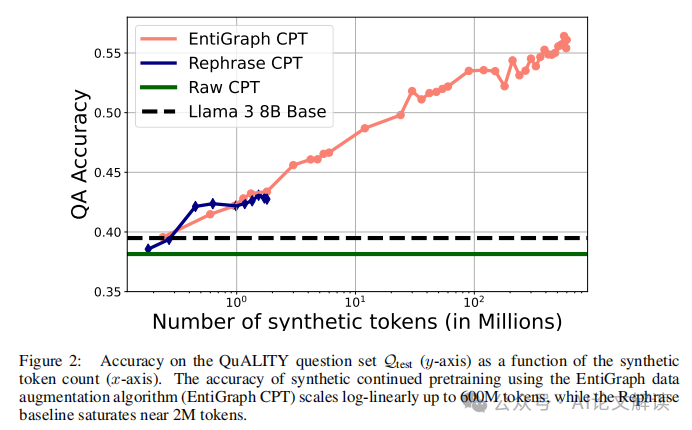

在使用EntiGraph生成的600M合成token進(jìn)行預(yù)訓(xùn)練后,我們觀察到模型在QuALITY問(wèn)題集上的表現(xiàn)顯著提升。具體來(lái)說(shuō),模型的問(wèn)答準(zhǔn)確率從基線模型的39.49%提高到56.42%。這一結(jié)果表明,合成持續(xù)預(yù)訓(xùn)練能夠有效地提高模型處理特定領(lǐng)域問(wèn)題的能力。

與基線模型的比較

我們還將EntiGraph預(yù)訓(xùn)練模型與兩個(gè)基線模型進(jìn)行了比較:

- 原始語(yǔ)料預(yù)訓(xùn)練(Raw CPT):直接在原始QuALITY文章上進(jìn)行預(yù)訓(xùn)練。

- 重述語(yǔ)料預(yù)訓(xùn)練(Rephrase CPT):在重述后的QuALITY文章上進(jìn)行預(yù)訓(xùn)練。

結(jié)果顯示,EntiGraph預(yù)訓(xùn)練模型在問(wèn)答任務(wù)上的表現(xiàn)顯著優(yōu)于這兩個(gè)基線模型,特別是與重述語(yǔ)料預(yù)訓(xùn)練模型相比,EntiGraph模型展示了更好的知識(shí)獲取和應(yīng)用能力。

數(shù)據(jù)增強(qiáng)的影響

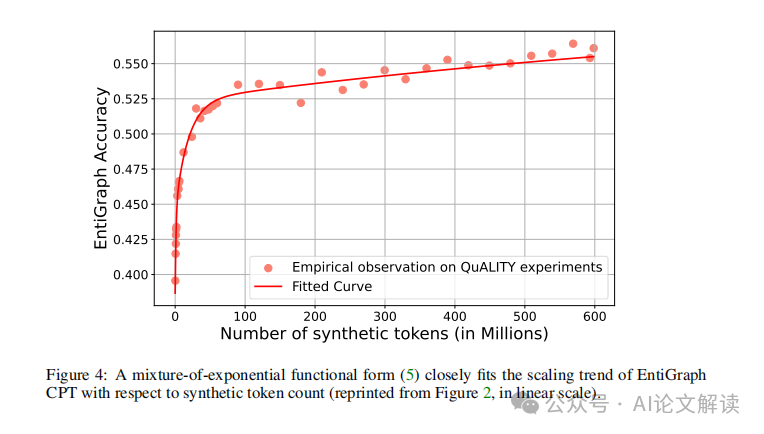

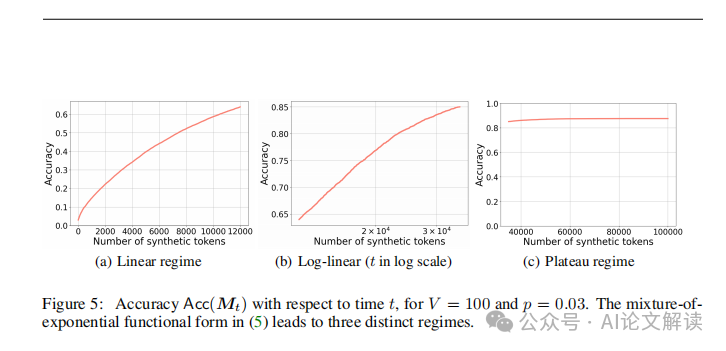

通過(guò)對(duì)比不同數(shù)量的合成token對(duì)模型性能的影響,我們發(fā)現(xiàn)模型的準(zhǔn)確率與使用的合成token數(shù)量呈對(duì)數(shù)線性關(guān)系。這一發(fā)現(xiàn)支持了我們的假設(shè):通過(guò)增加合成數(shù)據(jù)的多樣性和數(shù)量,可以有效地提升模型的學(xué)習(xí)效率和最終性能。

綜上所述,合成持續(xù)預(yù)訓(xùn)練和EntiGraph數(shù)據(jù)增強(qiáng)算法在提高語(yǔ)言模型從小規(guī)模、專業(yè)領(lǐng)域語(yǔ)料庫(kù)中學(xué)習(xí)的效率方面顯示出了顯著的潛力。這些結(jié)果為未來(lái)在更廣泛的應(yīng)用中使用合成數(shù)據(jù)生成技術(shù)提供了有價(jià)值的見(jiàn)解和證據(jù)。

總結(jié)

本研究提出了一種新穎的合成持續(xù)預(yù)訓(xùn)練方法,通過(guò)EntiGraph算法生成高質(zhì)量的合成數(shù)據(jù),有效地支持了小規(guī)模語(yǔ)料庫(kù)上的知識(shí)學(xué)習(xí)。實(shí)驗(yàn)結(jié)果表明,該方法能夠顯著提高模型在特定領(lǐng)域的表現(xiàn),尤其是在閉書(shū)問(wèn)答和指令遵循任務(wù)上。此外,我們還探討了合成數(shù)據(jù)的多樣性和質(zhì)量、模型的泛化能力以及計(jì)算效率和可擴(kuò)展性等未來(lái)的研究方向。

通過(guò)合成持續(xù)預(yù)訓(xùn)練,我們不僅提高了模型在特定領(lǐng)域的表現(xiàn),還為未來(lái)在數(shù)據(jù)受限環(huán)境下的模型訓(xùn)練提供了新的思路和方法。希望未來(lái)的研究能夠在此基礎(chǔ)上,進(jìn)一步探索和優(yōu)化合成數(shù)據(jù)生成和模型預(yù)訓(xùn)練的方法,以應(yīng)對(duì)更廣泛的應(yīng)用場(chǎng)景和挑戰(zhàn)。

本文轉(zhuǎn)載自 ??AI論文解讀??,作者:柏企