谷歌將大模型集成在實體機器人中,能看、聽、說執行57種任務

谷歌DeepMind在社交平臺分享了最新研究,將大模型Gemini 1.5 Pro集成在實體機器人中,為其提供導航、推理等服務。

由于缺乏高級認知、學習能力、語義理解以及數據存儲等,傳統機器人的“回憶能力”較差,無法提供更人性化的服務。而Gemini 1.5 Pro提供的100萬Tokens上下文長度,可有效解決這些難題,通過語音對話的方式將能讓機器人執行各種任務同時具備回憶的能力。

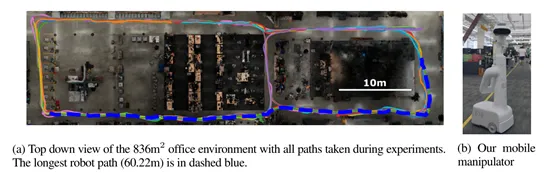

根據谷歌的測試結果顯示,在Gemini 1.5 Pro的幫助下,在836平方米的真實測試空間中,讓實體機器人執行了57種四大類型的指令任務,成功率平均在71%左右。

論文地址:https://arxiv.org/abs/2407.07775

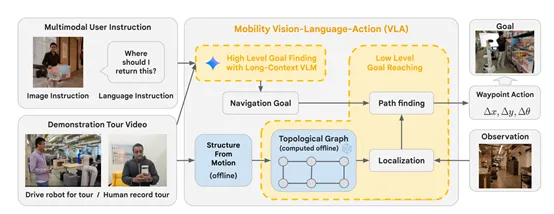

研究人員在Gemini 1.5 Pro的文本、圖像、音頻等能力基礎之上,開發了多模態視覺語言導航模型Mobility VLA。

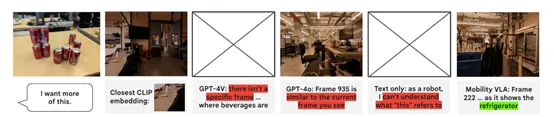

在Mobility VLA模型中,Gemini 1.5 Pro會被用來理解用戶的多模態指令。這些指令包括自然語言描述、圖像或者二者的結合,例如,當用戶手持一個物品并詢問“我應該把這個放在哪里?”時,Gemini 1.5 Pro需要能夠理解這一指令的語義內容,識別出用戶手中的物品。

在理解了用戶的語言指令后,接下來Gemini 1.5 Pro會在示范旅游視頻中定位與指令相關的目標幀。

一些示范數據提供了環境的先驗知識,Gemini 1.5 Pro通過分析這些視頻,能夠識別出與用戶指令相匹配的場景,并深入分析和對用戶指令的精確匹配,確保機器人能夠準確地導航到正確的位置。

在確定了目標幀后,Gemini 1.5 Pro的輸出將被用作Mobility VLA低層策略的輸入。

低層策略主要負責生成實體機器人的實際各種動作,包括前進、后退或轉向。Gemini 1.5 Pro通過其長上下文處理能力,能夠在整個視頻的背景下識別出最合適的目標幀,并將這些信息傳遞給低層策略,從而幫助機器人生成精確的導航路徑。

此外,Gemini 1.5 Pro在Mobility VLA模型中的作用不僅限于理解用戶指令和定位目標。憑借其超長的上下文處理能力,還有助于提升導航的準確性和魯棒性。

在復雜的真實環境中,機器人可能會遇到各種意外情況,例如,遭遇座椅等障礙物或實時的環境變化。Gemini 1.5 Pro能夠通過其對環境的深度理解,幫助機器人快速適應這些變化,對接下來的行動指令做出準確判斷,在面對復雜和動態的環境時,仍能保持高效的導航性能。

為了測試Mobility VLA在實體機器人的幫助能力,研究人員構建了一個836平方米的真實空間,里面有架子、桌子、椅子等各種日常家具,還使用了無需推理、需要推理、多模態等多種類型指令進行了綜合測試。

實驗結果顯示,在無需推理的20個指令中,機器人的成功率達到了80%,顯示出其在處理直接且明確的導航任務時的高效性。

在需要推理的15個指令中,機器人也達到了80%的成功率,這證明了其在理解和處理復雜用戶指令方面擁有相當出色的能力。

盡管在小物體類別都得12個指令中,成功率略有下降至40%,但這也在一定程度上反映了小物體識別的挑戰性。而在多模態的10個指令中,機器人的成功率再次提升至85%,顯示了其在整合視覺和語言信息方面的優勢。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區