QOQA:利用TopK文檔進行查詢改寫,平均提升RAG 1.6% 準確率

1. 背景

大型語言模型(LLMs)在眾多語言任務中展現出非常不錯的效果,然而,LLMs中的幻覺現象正極大地削弱它們的可信度和實用性。一種解決大語言模型幻覺的方法是檢索增強生成(RAG),通過檢索文檔來提供基于檢索到文檔中的事實信息的更準確的用戶查詢答復。

大語言模型幻覺(Hallucination)是指大語言模型產生錯誤或者誤導性的信息。

然而,RAG并未完全根除幻覺,這樣因此激發大量研究來提高RAG的準確性。一個不完善的RAG系統,常常因為模糊不清的查詢而引發誤導,導致沒能準確捕捉到用戶的真實意圖。

最新有研究表明,使用LLMs對用戶查詢進行擴展可以提升相關文檔的檢索效果。查詢擴展是指在原始查詢中加入更多相關術語,使得用戶的查詢更易與相關文檔相連。查詢擴展主要分為兩大類:

? 基于檢索器的方法通過利用檢索結果來拓展查詢

? 基于生成的方法則是借助大型語言模型(LLMs)等外部數據來豐富查詢內容

其中:

? 偽相關反饋(Pseudo Relevance Feedback,PRF)通過自動根據排名靠前的文檔調整初始查詢,進一步優化搜索結果,無需用戶明確輸入。PRF通過假定頂部結果的相關性,增強了查詢,從而提升了后續檢索的精確度。

? Query2Doc 研究顯示,將LLM生成的內容融合到查詢中,其效果明顯優于傳統的檢索技術。但這種方法也存在風險,可能會引入不準確信息,與目標文檔的匹配度不高,并且容易受到LLM幻覺的影響。

? 基于檢索的方法則通過引入相關術語或短語,增強了搜索查詢的實效性,使查詢更加豐富和精準。

? CSQE利用LLM從檢索到的文檔中提取關鍵句子進行查詢擴展,生成適應任務的查詢,盡管這有時會使得查詢變得過長。當將CSQE擴展的查詢與BM25評估的結果以及通過交叉編碼器從BEIR重新排名的結果進行比較時,發現性能提升并不顯著。

為了解決以上問題,本文作者提出了一種精確查詢優化方法(Query Optimization using Query expAnsion,QOQA),利用前k個平均查詢-文檔對齊得分,借助LLMs來精煉查詢。這種方法既計算效率高,又能提升文檔檢索的精確性,減少誤導。在實驗中,這種方法能夠以平均1.6%的提升率,準確提取所需文檔。

2. 什么是 QOQA?

2.1 借助大型語言模型(LLM)優化查詢

為了提升查詢質量,采用大型語言模型(LLM)根據得分對查詢進行改寫擴展。

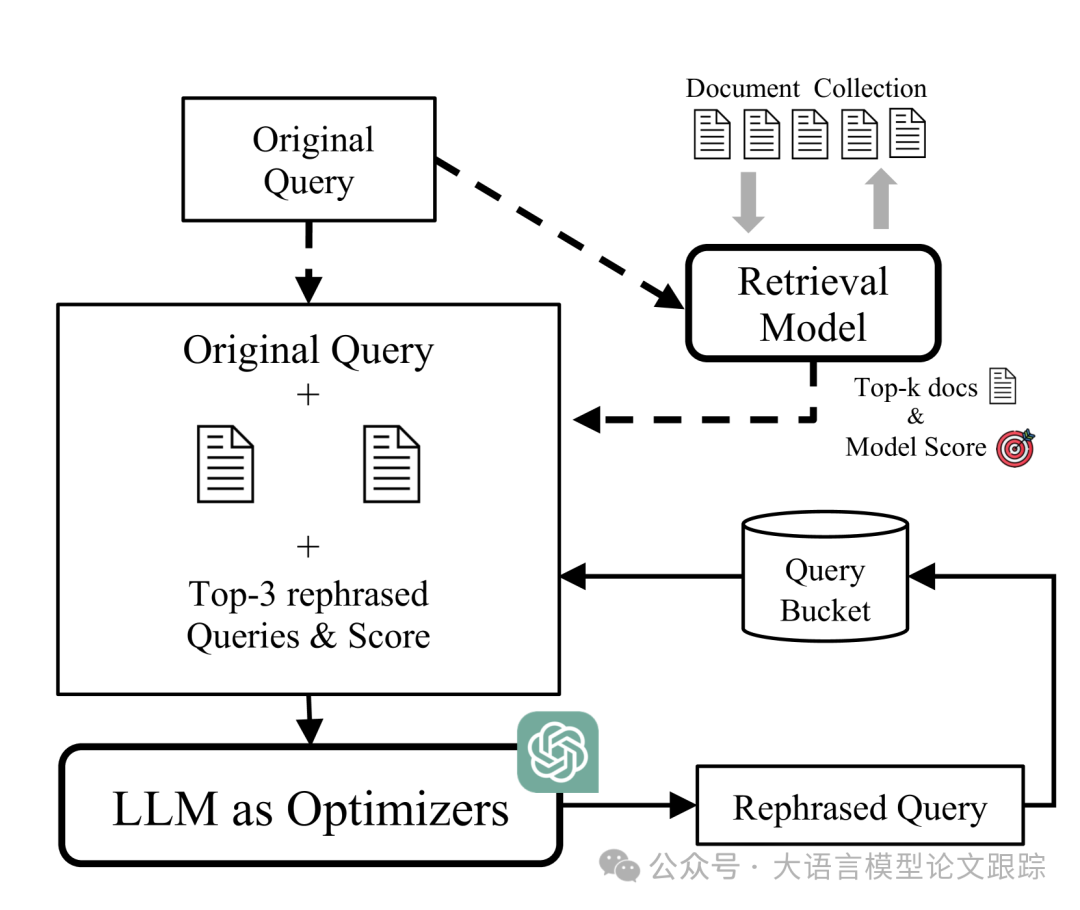

圖片

圖片

首先,輸入原始查詢,并通過檢索器獲取相關文檔。然后,將原始查詢與檢索到的頂級文檔合并,形成擴展查詢,并提交給LLM以產生一系列重新表述的查詢。

經過改寫的查詢將根據其與檢索文檔的契合度進行評估,相應的查詢-文檔對齊得分及其查詢文本將被存入查詢池。

圖片

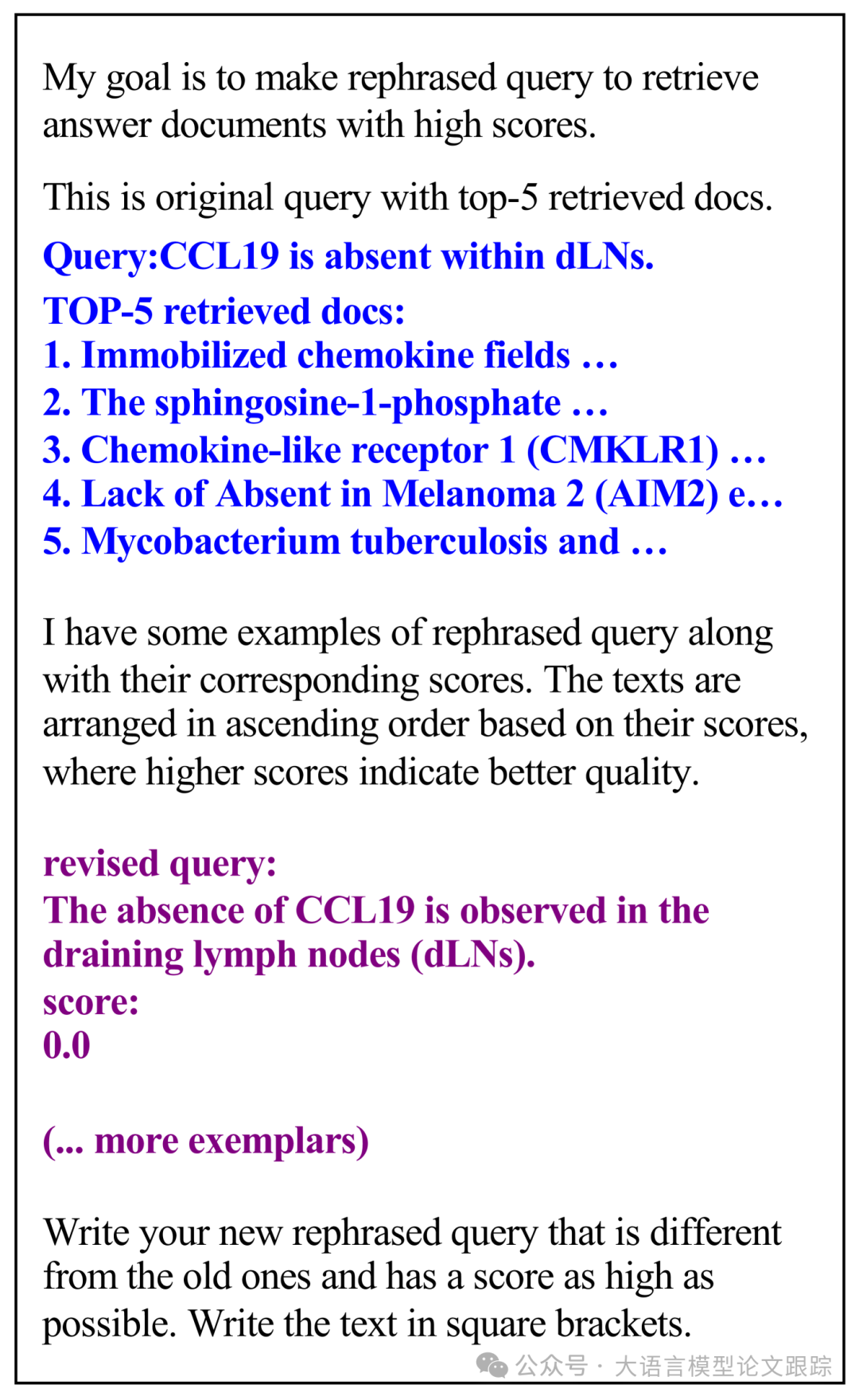

圖片

上圖展示了提示詞模板,將提示模板更新為包含原始查詢、檢索文檔以及排名靠前的查詢改寫。為確保性能超越原始查詢,始終在模板中融入原始查詢信息。在后續的優化環節,會根據得分生成一個經過優化的查詢,并將其加入到查詢池中。

上圖中,黑色文字是對任務描述的提示詞。藍色文字是原始查詢以及與之相關的頂級檢索文檔。紫色文字是由LLM優化器生成的改寫后查詢及其評分。

2.2 查詢-文檔對齊得分計算

2.1 中提到了一個查詢-文檔對齊得分,該得分涉及三個得分:

? 基于稀疏檢索的BM25分數

? 基于密集檢索的密集分數

? 融合了稀疏與密集檢索的混合分數

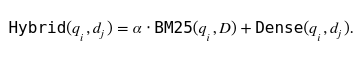

混合分數如下圖公式:

圖片

圖片

文章看上去沒有介紹這個 α參數 如何設置。

3. 效果對比

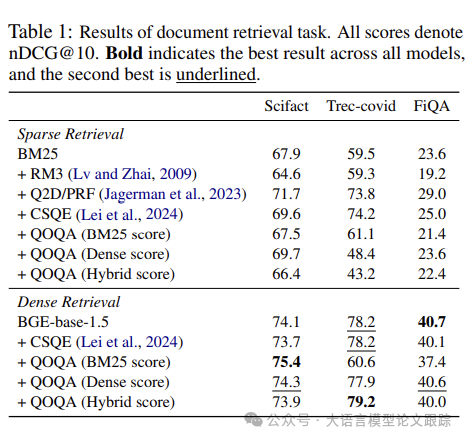

圖片

圖片

上表比較了不同文檔檢索模型在SciFact、Trec-Covid和FiQA數據集上的表現。在密集檢索方面,增強模型(QOQA變體)顯示出優越的性能。

特別地,QOQA(基于BM25評分)在SciFact數據集上以75.4分的優異成績領先,在Trec-Covid數據集上以79.2分的混合評分證明了其強大的性能。QOQA在多個數據集上一致的性能提升,凸顯了其在提升檢索效率方面的顯著效果。

圖片

圖片

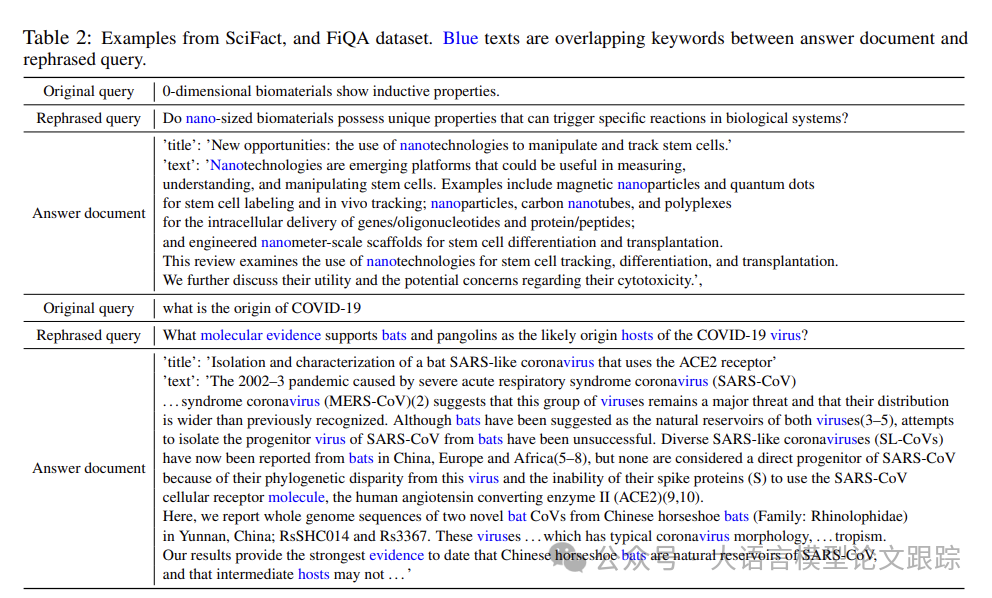

如上表,由QOQA生成的改寫查詢相較于原始查詢,在精確度和具體性上更勝一籌。

QOQA方法產生的查詢能夠精準地包含“納米”或“分子證據”等關鍵詞匯,從而有效抓取最為貼切的文檔。這種對關鍵詞的精準把控確保了改寫查詢與答案文檔在詞匯上的更高重合度。因此,借助QOQA優化的查詢在檢索包含正確答案的文檔時顯示出了顯著的效果。

圖片

圖片

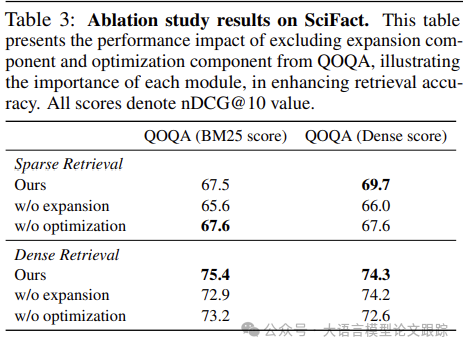

上表中可以看出,優化步驟對于搜索更佳的改寫查詢起到了促進作用。

缺少了擴展部分,整體性能尤其以BM25分數為標準,會有顯著的下降。

證明擴展部分在塑造高品質改寫查詢和提升文檔檢索效率方面發揮了不可或缺的作用。

本文轉載自??大語言模型論文跟蹤??,作者:HuggingAG