CVPR 2024 | 長時舞蹈生成:數秒鐘可生成極長的3D舞蹈

以下視頻來源于

THUSIGSICLAB

論文題目:

Lodge: A Coarse to Fine Diffusion Network for Long Dance Generation Guided by the Characteristic Dance Primitives

論文鏈接:

??https://arxiv.org/abs/2403.10518??

主頁鏈接:

??https://li-ronghui.github.io/lodge???

代碼鏈接:??https://github.com/li-ronghui/LODGE???

一、 研究動機

近年來,隨著生成式人工智能的快速發展,現有方法如FineDance[1] ,EDGE[2]已經展示出了數秒鐘高質量舞蹈的能力。然而,實際應用中的舞蹈表演和社交舞通常持續3至5分鐘,舞蹈劇可以持續15分鐘以上。因此,現有的舞蹈生成算法難以滿足實際需求,而如何生成高質量的長序列舞蹈動作成為了正待解決的問題。然而,生成長序列的舞蹈仍面臨著不少挑戰:

- 長序列數據顯著增大了計算開銷,如何開發計算友好的方法,提高訓練和推理階段的效率?

- 現有的方法主要采用自回歸模型,迭代地生成長序列舞蹈。然而這些方法往往面臨著誤差累積問題,且無法學習到全局的編舞規律。

- 由于神經網絡的訓練只關注與整體loss的收斂,因此網絡更傾向于生成保守的動作,這導致了最終的舞蹈缺少富有表現力的動作,展現出了平淡和中庸的效果。

我們認為現有的方法僅僅將舞蹈生成視為序列到序列的生成問題,他們努力提高細粒度局部細節的舞蹈質量,而忽略了音樂和舞蹈之間的全局編舞規律。參考[3][4],舞蹈通常是以從粗到細的方式編排的。提供完整的音樂,舞蹈設計師首先分析節奏、流派、情緒基調等音樂屬性,創造出“characteristic dance phrases”,即一些短暫的動作片段,具有強大的表現力和更豐富的語義信息。在這個階段,舞蹈設計師可以集中精力設計具有有特點的舞蹈短語,例如“倒立”和“太空步”。這些具有特色的舞蹈樂句按照音樂的結構化信息進行排列,整體的舞蹈結構就奠定了。隨后,通過將舞蹈短語與過渡動作連接起來,創作出整個舞蹈。

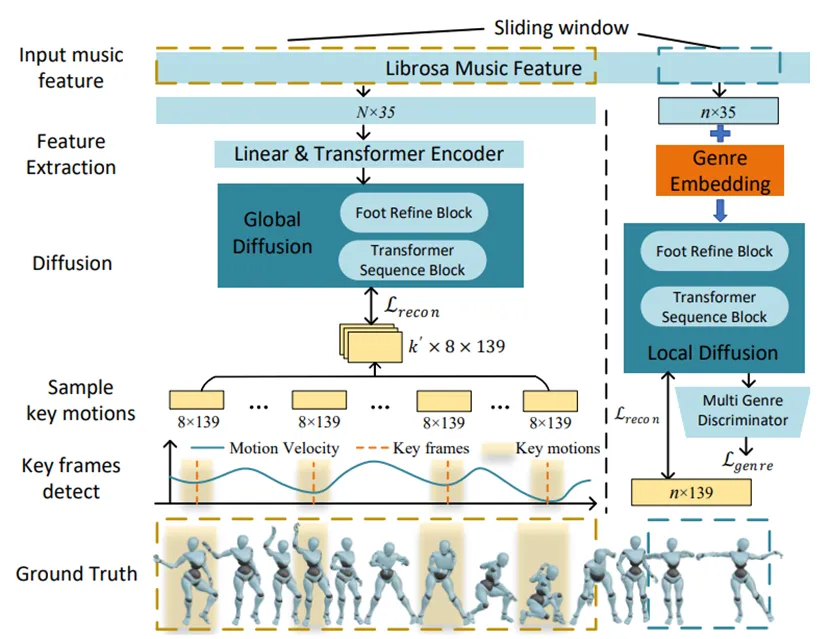

有了以上的認識之后,我們認為“dance phrases”包含豐富的獨特動作,可以傳遞全局的舞蹈模式。因此,與dance phrases類似,我們提出了適合網絡學習的 characteristic dance primitives。這些dance primitives是具有高運動能量的富有表現力的8幀關鍵動作,具有以下主要優點:(1)它們是稀疏的,從而減少了計算需求。(2)它們具有豐富的語義信息,并且可以傳遞編舞模式。(3)它們具有富有表現力的運動特征,可以指導運動擴散模型產生更多的動態運動并避免單調。

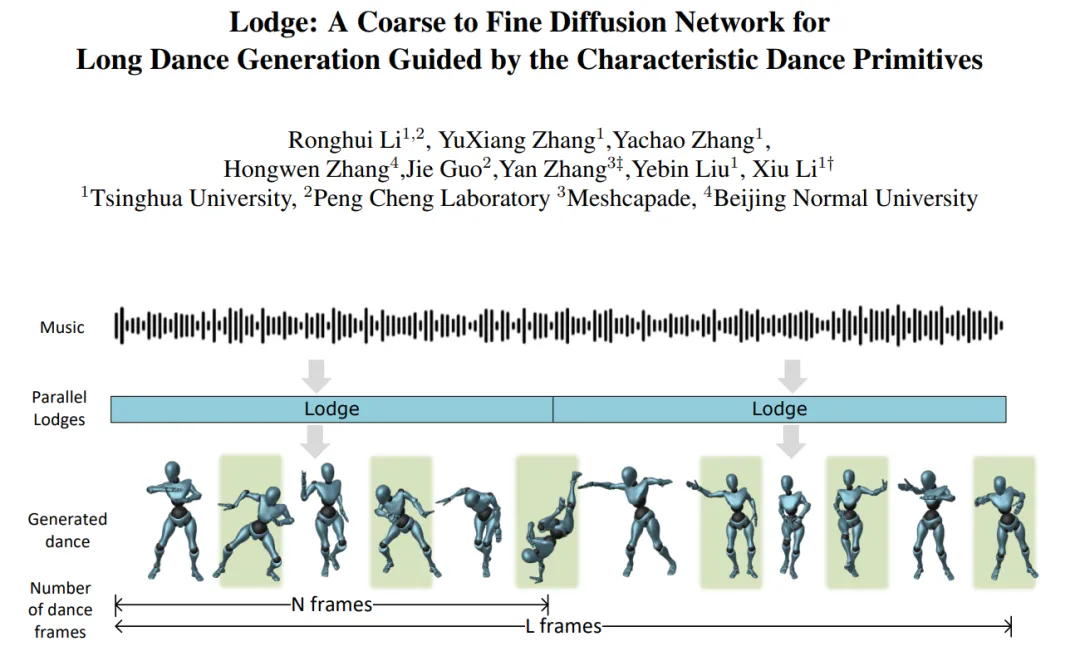

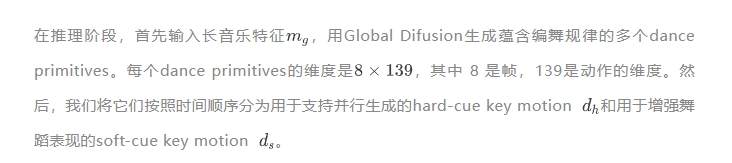

接下來,我們設計了一個具有兩個運動擴散模型的從粗到細的舞蹈生成框架,并采用 characteristic dance primitives 作為它們的中間表示。第一階段是粗粒度的全局擴散模型,它以長音樂作為輸入并產生dance primitives。隨后,我們采用并行局部擴散模型來獨立生成短舞蹈片段。基于一些已經生成的dance primitives,我們可以利用擴散引導來嚴格限制這些片段的開頭和結尾之間的一致性。因此,這些舞蹈片段可以串聯成一段連續的長舞蹈。同時,dance primitives的引導下,每個舞蹈片段的質量、表現力和多樣性都得到增強。

綜上所述,我們的主要貢獻如下:

- 我們提出了一個可以并行生成長舞蹈的擴散模型。我們的方法能夠學習整體的編舞模式,同時保證局部動作的質量。并行生成策略可以在數秒鐘生成極長的3D舞蹈。

- 我們提出了characteristic dance primitives作為兩個擴散模型之間的中間表示,提高了生成舞蹈的張力。

- 我們提出了一個腳部優化模塊,并采用足部與地面的接觸損失來緩解腳步和地面接觸的問題諸如腳滑、腳部漂浮和腳與地面穿模等。

二、方法

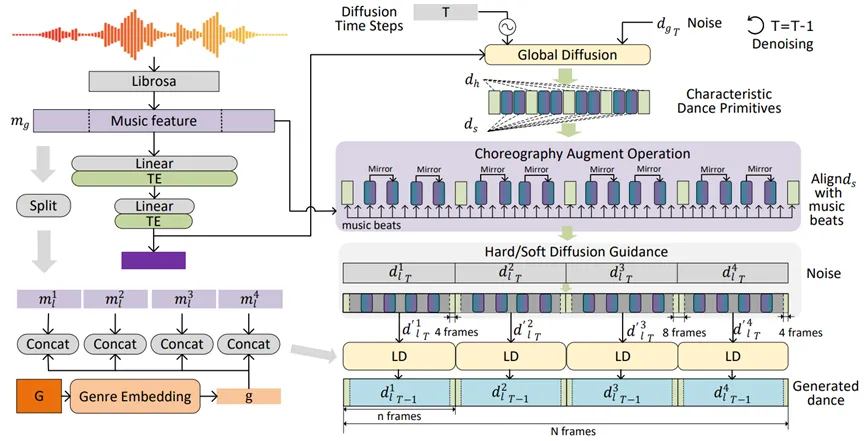

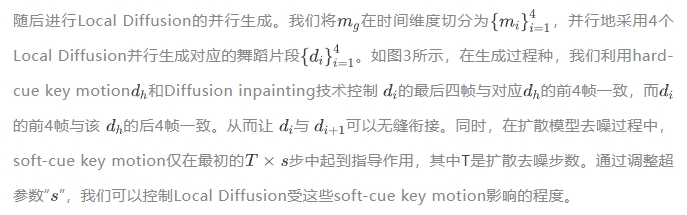

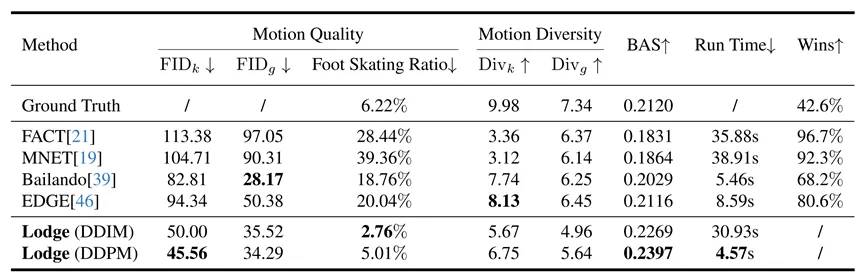

為了同時考慮全局編舞規律和局部舞蹈質量,我們設計了一個由粗到細的兩階段的擴散網絡,分別是Global Diffusion Model和Local Diffusion Model。兩個模型可以獨立地訓練。Global Diffusion Model在更大的時間尺度上學習全局編舞規律,為了讓Global Diffusion生成characteristic dance primitives,我們從對應的舞蹈序列種提取一些運動速度的極值點,并將這些極值點附近的8幀有表現力的關鍵動作片段做為Global Diffusion訓練的Ground Truth。而Local Diffusion Model在一個較小的時間尺度上學習如何生成高質量的短時舞蹈片段。

圖1. Lodge訓練過程。

圖2. Lodge推理過程。“TE”為Transformer Encoder,“LD”為Local Diffusion。

圖3. Hard/Soft Diffusion Guidance

更多的技術細節請參考我們的論文。

三、實驗

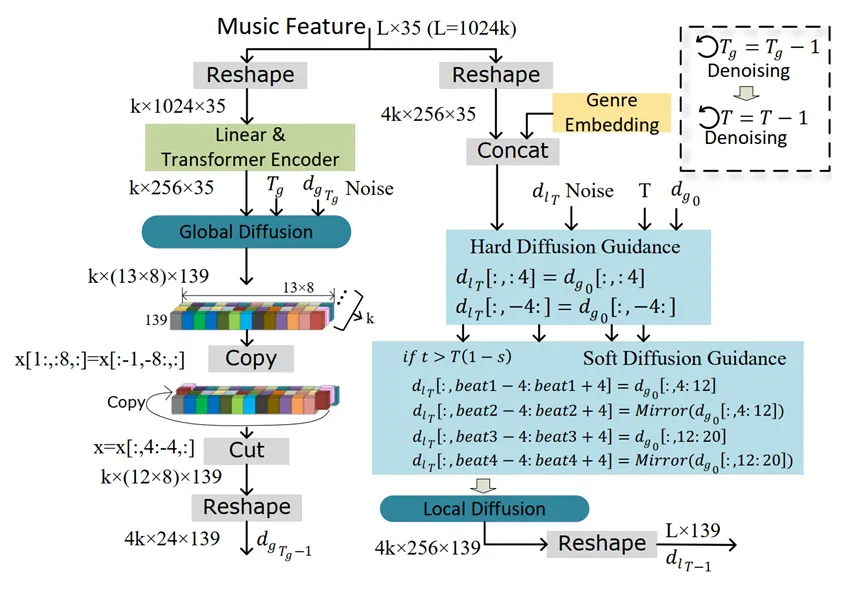

我們在FineDance[1]和AIST++[5]兩個數據集上進行實驗。由于FineDance平均每段舞蹈的時長是152.3秒,遠高于AIST++的13.3秒,因此我們主要用FineDance數據集進行訓練和測試。

表1. 在FineDacne數據集上與其他方法對比。

值得一提的是,采用DDIM采樣策略可以獲得不錯的性能,并且生成1024幀舞蹈的推理時間降低到了4.57s。而得益于我們的并行生成架構,繼續增大需要生成的舞蹈的序列長度,推理時間也不會顯著增大。

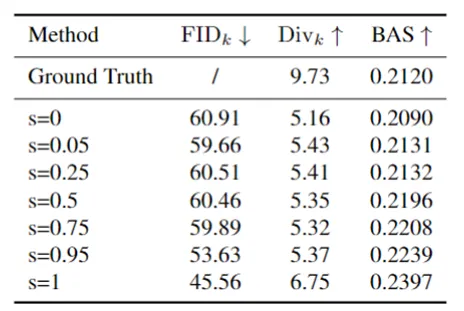

表2. 超參數“s”的消融實驗,測試于FineDance數據集。

我們的soft-cue key motion對結果的影響程度可以使用超參數“s”進行調整,其中“s”值越大表示效果越強。表2 展示了設置各種“s”值所產生的結果。隨著“s”的增加,和節拍對齊分數BAS也相應增強。當“s”設置為 1 時,可獲得最佳的性能。

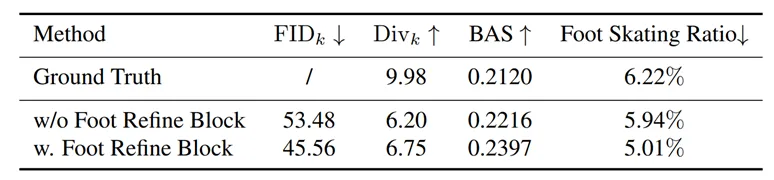

表3. Foot Refine Block的消融實驗,測試于FineDance數據集。

如表3所示,加入Foot Refine Block后,運動質量FID_k有了很大的改善,特別是Foot Skating Ratio從5.94%下降到5.01%,這證明我們提出的Foot Refine Block可以有效改善腳部與地面的接觸質量,降低腳部腳滑現象出現的頻率。

四、總結

在這項工作中,我們引入了 Lodge,一種兩級從粗到細的擴散網絡,并提出characteristic dance primitives作為兩個擴散模型的中間級表示。Lodge 已通過用戶研究和標準指標進行了廣泛的評估,取得了最先進的結果。我們生成的樣本表明,Lodge 可以并行生成符合編舞規則的舞蹈,同時保留局部細節和物理真實感。廣泛的消融實驗驗證了我們不同模塊、粗到細框架、舞蹈基元和足部細化網絡的有效性。然而,我們的方法目前無法生成帶有手勢或面部表情的舞蹈動作,這對于表演也至關重要。我們將很高興在未來看到長序列全身舞蹈生成的新工作。

參考文獻

[1] Li, Ronghui, et al. "FineDance: A Fine-grained Choreography Dataset for 3D Full Body Dance Generation." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2023.

[2] Tseng, Jonathan, Rodrigo Castellon, and Karen Liu. "Edge: Editable dance generation from music." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023.

[3] Blom, Lynne Anne, and L. Tarin Chaplin. The intimate act of choreography. University of Pittsburgh Pre, 1982.

[4] Chen, Kang, et al. "Choreomaster: choreography-oriented music-driven dance synthesis." ACM Transactions on Graphics (TOG) 40.4 (2021): 1-13.

[5] Li, Ruilong, et al. "Ai choreographer: Music conditioned 3d dance generation with aist++." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2021.

[6] Huang, Ruozi, et al. "Dance revolution: Long-term dance generation with music via curriculum learning." arXiv preprint arXiv:2006.06119 (2020).

[7] Siyao, Li, et al. "Bailando: 3d dance generation by actor-critic gpt with choreographic memory." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.Illustration From IconScout By 22

本文轉載自??將門創投??,作者:李镕輝