最全梳理多模態大模型近期進展(26個最佳方案匯總) 精華

paper:https://arxiv.org/abs/2401.13601

一篇比較不錯的綜述型文章

- 梳理了多模態大型語言模型(MM-LLM) 的近期進展

- 總結了 MM-LLM 的模型架構和訓練流程

- 梳理了 26 個當前最佳的 MM-LLM模型

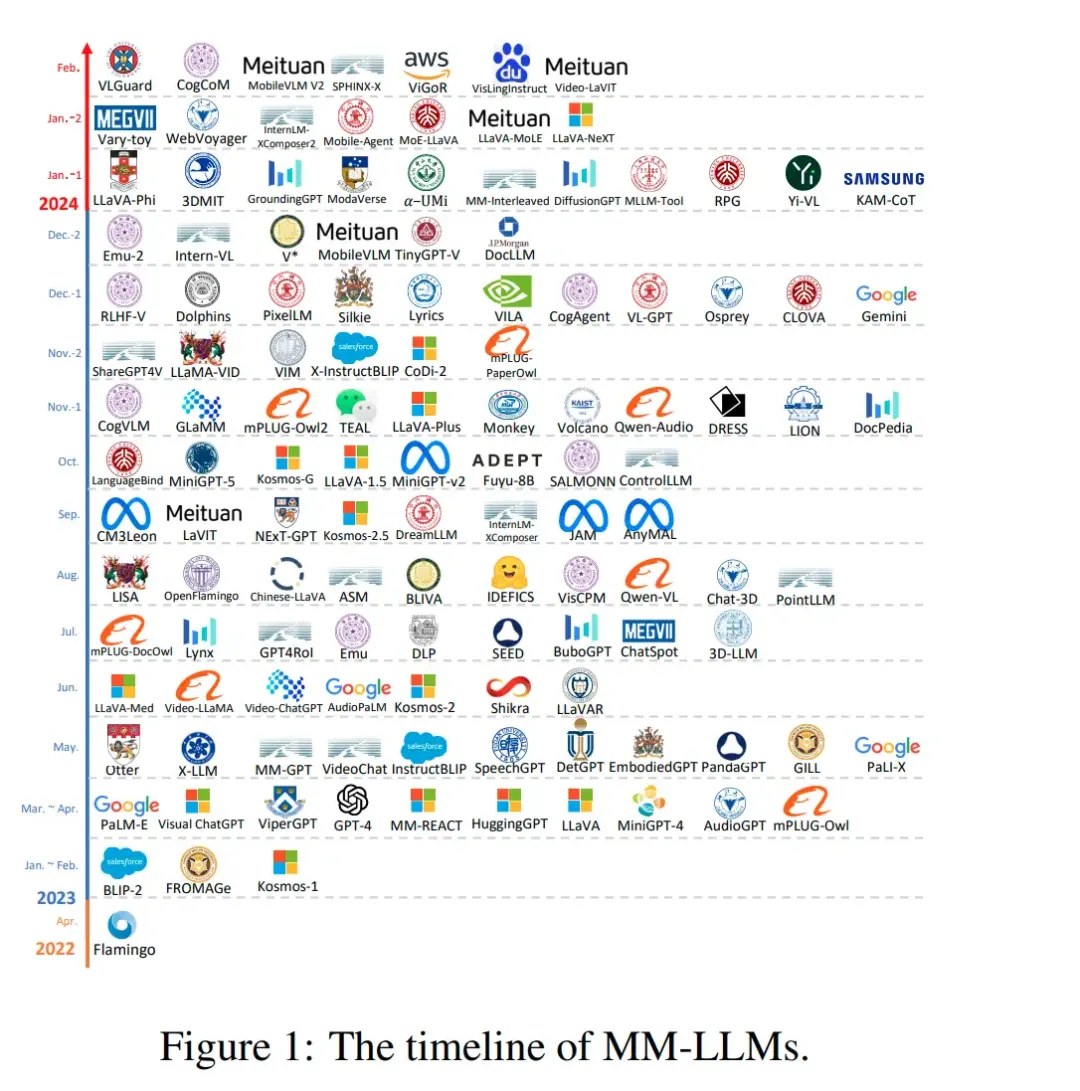

MM-LLM 的時間線

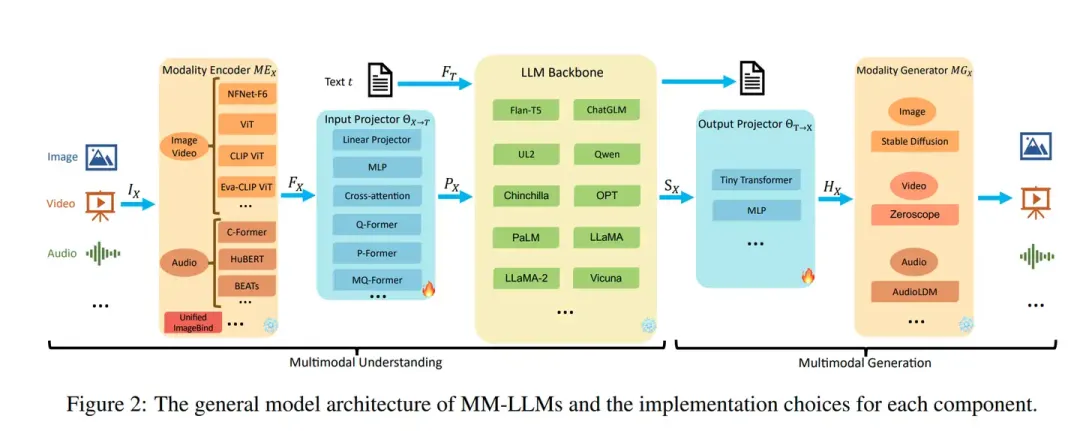

主要模型架構

模型架構

- 模態編碼器(Modality Encoder/ME):

- 圖像:NFNet-F6、ViT、CLIP ViT等。

- 視頻:通常將視頻均勻采樣成5幀,經過與圖像相同的預處理。

- 音頻:CFormer、HuBERT、BEATs等。

- 3D點云:ULIP-2與PointBERT后端。

- 負責將不同模態的輸入編碼成特征表示,例如圖像、視頻、音頻等。

- 針對不同的模態,有多種預訓練的編碼器選項,例如:

- 輸入投影器(Input Projector):

- 將編碼的特征與文本特征空間對齊,以便輸入到LLM主干。

- 這通常通過線性投影器或多層感知器(MLP)實現,也可以使用更復雜的實現,如交叉注意力、Q-Former、P-Former和MQ-Former。

- LLM 骨干(LLM Backbone):

- 作為模型的核心,處理來自不同模態的特征,進行語義理解、推理和決策。

- 采用大型語言模型作為核心代理,處理來自不同模態的表示,進行語義理解、推理和決策。

- 輸出投影器(Output Projector):

- 將LLM主干的輸出映射回模態生成器能夠理解的特征。

- 這通常通過小型變換器或MLP實現,目的是最小化映射特征與模態生成器的條件文本表示之間的距離。

- 模態生成器:

- 模態生成器的任務是生成不同模態的輸出,通常使用現成的潛在擴散模型(LDMs)。

- 例如,Stable Diffusion用于圖像合成,Zeroscope用于視頻合成,AudioLDM2用于音頻合成。

訓練流程(Training Pipeline)

- MM-LLMs的訓練流程分為兩個主要階段:多模態預訓練(MM PT)和多模態指令微調(MM IT)。

- 在MM PT階段,通過優化預定義的目標來訓練輸入和輸出投影器,實現不同模態之間的對齊。

- 在MM IT階段,使用指令格式化的數據集對預訓練的MM-LLMs進行微調,以提高模型對未見任務的泛化能力。

多模態預訓練(MM PT)

在這一階段,通過優化預定義的目標來訓練輸入和輸出投影器,實現不同模態之間的對齊。

一般而言,只訓練輸出投影器與輸出投影器,實現不同模態之間的對齊,以便LLM主干能夠有效地處理多模態輸入。在訓練階段,模態編碼器、LLM 骨干和模態生成器通常保持在凍結狀態;由于投影器是輕量級的組件,因此相比于總參數量,MM-LLM 中可訓練參數的占比非常小(通常約為 2%)。總參數量取決于 MM-LLM 中使用的核心 LLM 的規模。因此,在針對各種多模態任務訓練 MM-LLM 時,可以取得很高的訓練效率。

數據集:通常使用X-Text數據集,這些數據集包含圖像-文本(Image-Text)、視頻-文本(Video-Text)和音頻-文本(Audio-Text)對,以及交錯的圖像-文本語料庫(interleaved Image-Text corpus)。

優化:訓練過程中,主要優化的是IP和OP的參數,以最小化條件文本生成損失(Ltxt-gen)。這通常涉及到將模態編碼器的輸出特征(FX)與文本特征(FT)對齊,生成的對齊特征(PX)作為LLM主干的輸入。

多模態指令調優(MM IT)

使用指令格式化的數據集對預訓練的MM-LLMs進行微調,以提高模型對未見任務的泛化能力。

MM IT 這種方法需要使用一組指令格式的數據集對預訓練的 MM-LLM 進行微調。通過這個微調過程,MM-LLM 可以泛化到未曾見過的任務,執行新指令,從而增強零樣本性能。

MM IT 包含監督式微調(SFT)和根據人類反饋的強化學習(RLHF),目標是與人類意圖或偏好對齊并提升 MM-LLM 的交互能力。

SFT 可將預訓練階段的部分數據轉換成指令感知型的格式。

SFT 之后,RLHF 會對模型進行進一步的微調,這需要有關 MM-LLM 所給響應的反饋信息(比如由人類或 AI 標注的自然語言反饋(NLF))。這個過程采用了一種強化學習算法來有效整合不可微分的 NLF。模型的訓練目標是根據 NLF 生成對應的響應。

現有的 MM-LLM 在 MM PT 和 MM IT 階段使用的數據集有很多,但它們都是表 3 和表 4 中數據集的子集。

26個sota模型

該團隊比較了 26 個當前最佳(SOTA)MM-LLM 的架構和訓練數據集規模,如表 1 所示。另外他們還簡單總結了每種模型的核心貢獻和發展趨勢。這些模型代表了多模態大型語言模型領域的最新進展,涵蓋了從理解到生成、從單模態到多模態交互的各個方面。每個模型都在特定的任務或數據集上展示了其獨特的優勢和能力。

26個sota模型

- Flamingo:一個視覺語言模型,專為處理交錯的視覺數據和文本而設計,能夠生成自由形式的文本作為輸出。

- BLIP-2:引入了一個資源高效的框架,使用輕量級Q-Former橋接模態間的差距,并利用凍結的LLMs進行零樣本圖像到文本的生成。

- LLaVA:將指令微調(IT)技術轉移到多模態領域,為解決數據稀缺問題,引入了新的開源多模態指令遵循數據集和基準測試。

- MiniGPT-4:提出一種簡化的方法,只訓練一個線性層來對齊預訓練的視覺編碼器與LLM,以復制GPT-4展示的能力。

- mPLUG-Owl:提出了一種新的模塊化訓練框架,包含視覺上下文,并引入了一個評估不同模型在多模態任務中表現的指令評估數據集。

- X-LLM:擴展到包括音頻在內的各種模態,并展示了強大的可擴展性,利用Q-Former的語言遷移能力,在漢藏語系的背景下成功應用。

- VideoChat:首次提出了一個以聊天為中心的多模態大型語言模型,用于視頻理解對話,為學術界和工業界提供了標準和協議。

- InstructBLIP:基于預訓練的BLIP-2模型進行訓練,只更新Q-Former,在多模態指令微調中引入了指令感知的視覺特征提取和相應指令。

- PandaGPT:一個開創性的通用模型,能夠理解和執行跨6種不同模態的指令:文本、圖像/視頻、音頻、熱成像、深度和慣性測量單元。

- PaLI-X:使用混合視覺語言目標和單模態目標進行訓練,包括前綴完成和掩蔽標記完成,對下游任務結果和微調設置中的帕累托前沿都有效。

- Video-LLaMA:引入了一個多分支跨模態預訓練框架,使LLMs能夠同時處理給定視頻的視覺和音頻內容,并與人類進行對話。

- Video-ChatGPT:專為視頻對話設計,能夠通過整合時空視覺表示來生成關于視頻的討論。

- Shikra:為指代表話而設計的一個簡單而統一的預訓練多模態大型語言模型,涉及對圖像中區域和對象的討論。

- DLP:提出了P-Former來預測理想的提示,訓練在單模態句子數據集上,展示了單模態訓練增強多模態學習的可能性。

- BuboGPT:通過學習共享的語義空間構建的模型,全面理解多模態內容。

- ChatSpot:引入了一種簡單而有效的方法,通過精確的指代表達指令微調多模態大型語言模型,促進細粒度的交互。

- Qwen-VL:支持英語和中文的多語言多模態大型語言模型,允許在訓練階段輸入多張圖片,提高了對視覺上下文的理解能力。

- NExT-GPT:一個端到端的通用多模態大型語言模型,支持圖像、視頻、音頻和文本的自由輸入和輸出。

- MiniGPT-5:與生成vokens和與Stable Diffusion集成的多模態大型語言模型,擅長執行多模態生成的視覺語言輸出。

- LLaVA-1.5:對LLaVA框架進行了簡單修改,包括應用MLP投影和引入針對學術任務量身定制的VQA數據。

- MiniGPT-v2:作為統一接口設計的多模態大型語言模型,用于處理多種視覺語言多任務學習。

- CogVLM:一個開源的多模態大型語言模型,通過在注意力和前饋層中嵌入可訓練的視覺專家模塊來彌合模態之間的差距。

- DRESS:使用自然語言反饋來增強與人類偏好的一致性,將條件強化學習算法擴展到整合不可微的自然語言反饋。

- X-InstructBLIP:引入了一個跨模態框架,具有指令感知的表示,足以使LLMs能夠處理包括圖像/視頻、音頻和3D在內的多種任務。

- CoDi-2:一個多模態生成模型,擅長模態交錯指令遵循、上下文生成和通過多輪對話的用戶體驗交互。

- VILA:在視覺任務中表現出色的多模態大型語言模型,展示了卓越的推理能力,同時保持了僅文本的能力。

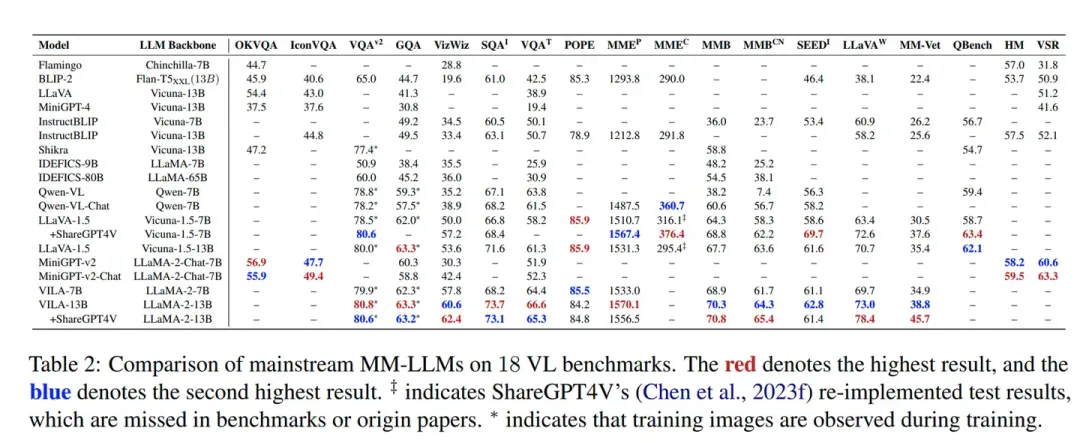

性能評估

性能評估旨在通過一系列標準化的基準測試來衡量和比較不同MM-LLMs的性能。這些基準測試覆蓋了多種任務,包括但不限于圖像-文本理解、視頻-文本理解和音頻-文本理解。

基準測試選擇

論文中提到了18個主要的VL基準測試,這些基準測試包括OKVQA、IconVQA、VQAv2、GQA等,每個測試都針對特定的多模態任務設計,能夠全面評估模型在不同方面的性能。

評估標準

- 準確性:模型回答問題或完成任務的準確度。

- 魯棒性:模型在面對不同類型或困難的輸入時的表現。

- 泛化能力:模型對未見數據的適應能力。

模型表現

論文中對多個MM-LLMs在上述基準測試中的表現進行了比較。例如,對于圖像-文本理解任務,BLIP-2、LLaVA和MiniGPT-4等模型在不同的基準測試上展示了它們的能力。

關鍵訓練方法

為了提高MM-LLMs的效能,論文總結了一些關鍵的訓練方法,包括:

- 數據增強:通過增加數據的多樣性來提高模型的泛化能力。

- 模態融合:改進不同模態之間的信息融合策略,以提高理解能力。

- 指令微調:使用特定任務的指令來微調模型,提高其對特定任務的適應性。

未來方向

更通用和智能的模型(More General and Intelligent Models)

- 擴展模態(Expanding Modalities):探索將MM-LLMs擴展到更多模態,如網頁、熱圖、圖表等,以提高模型的通用性和適用性。

- 多樣化的LLMs(Diversifying LLMs):使用不同類型的LLMs,為特定需求提供選擇最合適模型的靈活性。

- 提高多模態指令微調數據集質量(Improving MM IT Dataset Quality):改進和擴展現有的MM IT數據集,以提高模型理解和執行用戶指令的有效性。

- 加強多模態生成能力(Strengthening MM Generation Capabilities):雖然當前的MM-LLMs主要關注多模態理解,但提高生成響應的質量也是重要的研究方向。

更具挑戰性的基準測試(More Challenging Benchmarks)

現有的基準測試可能不足以充分挑戰MM-LLMs的能力,需要構建更具挑戰性、更大規模的基準測試,涵蓋更多模態,并采用統一的評估標準。

移動/輕量級部署(Mobile/Lightweight Deployment)

為了在資源受限的平臺上部署MM-LLMs并實現最佳性能,需要輕量化實現。例如,MobileVLM通過戰略性地縮小LLaMA模型,實現了無縫的即插即用部署。

體現智能(Embodied Intelligence)

體現智能旨在通過有效理解環境、識別相關對象、評估空間關系和制定綜合任務計劃,復制類似人類的感知和與環境的交互。

持續學習(Continual Learning)

由于MM-LLMs的大規模訓練成本,頻繁重新訓練是不可行的。因此,需要持續學習機制,使模型能夠靈活地、持續地利用新數據,同時避免重新訓練的高成本。

減少幻覺(Mitigating Hallucination)

幻覺問題涉及在沒有視覺線索的情況下生成對不存在對象的文本描述。需要新的方法來減少這些幻覺,提高輸出的可靠性。

偏見和倫理考慮(Biases and Ethical Considerations)

確保MM-LLMs的安全和有效應用至關重要。需要開發新的基準測試來評估MM-LLMs中的偏見,并設計更有效和細粒度的對齊方法。

本文轉自 AI生成未來 ,作者:羅清雨