ACM最新論文戳破大公司「開源」謊言,GenAI時(shí)代到底如何定義「開源模型」

當(dāng)我們?cè)谡務(wù)摗搁_源」時(shí),我們到底在談?wù)撌裁矗?/p>

在軟件時(shí)代,「開源」的概念并不模糊。我們可以非常清楚自信地說,Linux是開源的,Windows是閉源的。

更具體地說,曾經(jīng)的「開源」是指能夠訪問、修改源代碼,并對(duì)程序的使用或發(fā)行不加限制。

但進(jìn)入AI時(shí)代,這個(gè)概念變得愈發(fā)模糊。關(guān)于人工智能模型的「開源」到底如何界定,社區(qū)和行業(yè)專家仍未達(dá)成一致。

成立于1998年的Open Source Initiative(OSI)就始終在主持一個(gè)在線論壇,方便對(duì)開源AI模型的定義進(jìn)行公開討論。

他們?cè)诠俜骄W(wǎng)站上表示:「對(duì)于開源代碼和使用許可的傳統(tǒng)觀點(diǎn)不再適用于AI組件,已經(jīng)不足以保證使用、研究、共享和修改系統(tǒng)的自由。」

OSI的開源AI定義草案從2022年發(fā)起,已經(jīng)修改到了版本0.0.8,最新一版中宣稱,開源AI系統(tǒng)應(yīng)該提供以下三個(gè)方面的信息:

- 訓(xùn)練數(shù)據(jù)的詳細(xì)信息,包括數(shù)據(jù)集、數(shù)據(jù)來源、數(shù)據(jù)范圍和特征、獲取和數(shù)據(jù)選擇方式、標(biāo)注程序、數(shù)據(jù)清理方法等,以便技術(shù)人員可以用相同或相似的數(shù)據(jù)復(fù)現(xiàn)模型的效果

- 用于訓(xùn)練和運(yùn)行的源代碼,包括支持庫以及預(yù)處理、訓(xùn)練、驗(yàn)證和測(cè)試、推理、模型架構(gòu)等多步驟的代碼

- 模型參數(shù),包括訓(xùn)練階段中間關(guān)鍵的檢查點(diǎn)(checkpoint)以及最終的優(yōu)化器狀態(tài)

這相比我們平常認(rèn)知中的「開放源代碼」已經(jīng)擴(kuò)展了不少內(nèi)容。

最近,荷蘭的兩位學(xué)者也注意到了AI行業(yè)「開源」這個(gè)定義的模糊性,于是發(fā)表了一篇論文討論這個(gè)問題。

文章已被ACM下轄的FAccT會(huì)議(Fairness, Accountability and Transparency)接收,并得到了Nature的報(bào)道。

論文地址:https://dl.acm.org/doi/10.1145/3630106.3659005

本文創(chuàng)建了一個(gè)排行榜,用于識(shí)別最「開放」和最「不開放」的模型,并譴責(zé)了大公司「掛羊頭賣狗肉」的行為。

共同一作Dingemanse表示,一些大公司聲稱自己的模型開源并從中獲益,卻試圖盡可能少地披露模型信息。論文將這種行為幽默地比喻為open-washing(源于「洗白」white-washing一詞)。

這篇論文也得到了同行的認(rèn)可,Mozilla基金會(huì)可信AI方面的高級(jí)研究員Abeba Birhane稱贊這項(xiàng)研究「戳破了當(dāng)前開源討論中的大量炒作和廢話」。

大公司open-washing,開源≠開放

給模型貼上「開源」的標(biāo)簽,不僅對(duì)社區(qū)和開發(fā)者有不可抗拒的誘惑力,也能在法律和商業(yè)層面帶來豐厚回報(bào)。

將模型開源的行為,似乎讓研發(fā)團(tuán)隊(duì)顯得更加嚴(yán)謹(jǐn)、透明,而且看起來不那么鉆營(yíng)于短期利益,而是致力于整個(gè)AI行業(yè)的長(zhǎng)遠(yuǎn)發(fā)展。

此外,歐盟今年通過的人工智能法案也對(duì)開源的通用模型有一定的豁免,沒有那么高的透明度要求,讓它們承擔(dān)「較少且尚未定義」的義務(wù)。

在這樣的背景下,許多LLM都是頂著「開源」光環(huán)出道的,標(biāo)志之一就是使用博客文章發(fā)布模型。

論文發(fā)現(xiàn),大公司發(fā)布模型的博客文章中會(huì)包含精心設(shè)計(jì)的表格,并在MMLU、HumanEval、TruthQA等基準(zhǔn)上進(jìn)行打分測(cè)試。

這讓發(fā)布者保留了科學(xué)研究的光環(huán),但又巧妙避免了真正發(fā)布科研論文時(shí)需要面臨的詳細(xì)審查與同行評(píng)審,從而不必被迫披露不想公開的數(shù)據(jù)。

那么到底應(yīng)該用什么樣的標(biāo)準(zhǔn)定義「開源」?

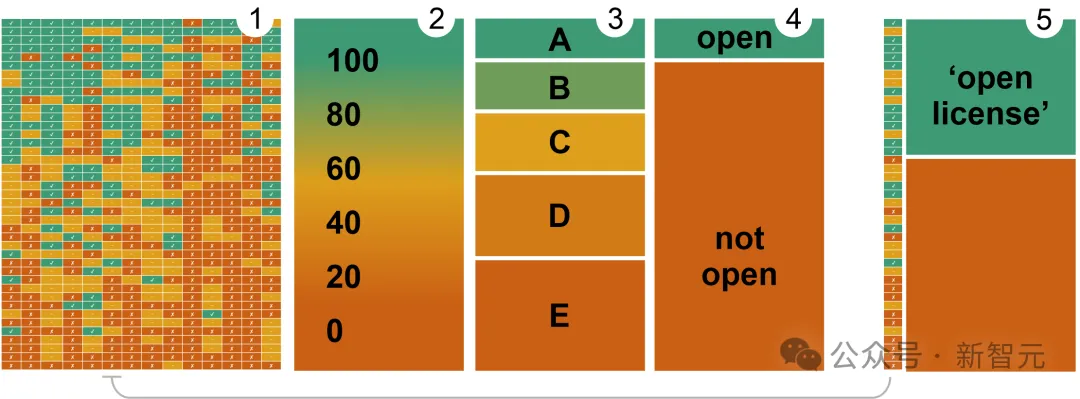

論文提出,鑒于GenAI系統(tǒng)的復(fù)雜性,最有效的方法將是把「開放性」視為一個(gè)復(fù)合且分級(jí)的概念。

「復(fù)合」體現(xiàn)在由多個(gè)因素組成,其中每個(gè)因素都可以單獨(dú)進(jìn)行評(píng)估;「分級(jí)」是因?yàn)槊總€(gè)維度都能以不同的程度實(shí)現(xiàn)開放,不能賦以「開放/封閉」這樣簡(jiǎn)單的二元?jiǎng)澐帧?/p>

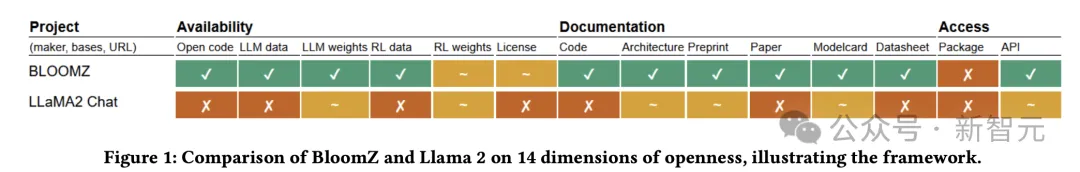

于是,對(duì)46個(gè)聲稱「開源」或「開放」的大模型以及眾多小型模型,作者進(jìn)行了多維度的評(píng)估與對(duì)比,在14個(gè)參數(shù)上進(jìn)行了三分類:開放(open)、部分開放(partially open)還是封閉(closed)。

專注于開放技術(shù)的非營(yíng)利公司OpenUK的CEO認(rèn)為,在分析開放程度時(shí),使用這種滑動(dòng)尺度取代簡(jiǎn)單粗暴的分類,是更加實(shí)際且有用的方法。

14個(gè)參數(shù)涵蓋了3個(gè)方面——

- 可用性:包括代碼、數(shù)據(jù)、模型權(quán)重、指令微調(diào)的數(shù)據(jù)、微調(diào)后的權(quán)重

- 文檔:源代碼、模型架構(gòu)的說明文檔,模型卡(model card)、數(shù)據(jù)表(data sheet)、是否發(fā)布了預(yù)印本和經(jīng)過同行評(píng)審的論文

- 訪問與許可:是否把模型放到公開代碼庫上(如PyPI)作為軟件包發(fā)行,是否提供API訪問,以及模型的許可證

綠色表示開放,黃色表示部分開放,紅色表示封閉

評(píng)估結(jié)果

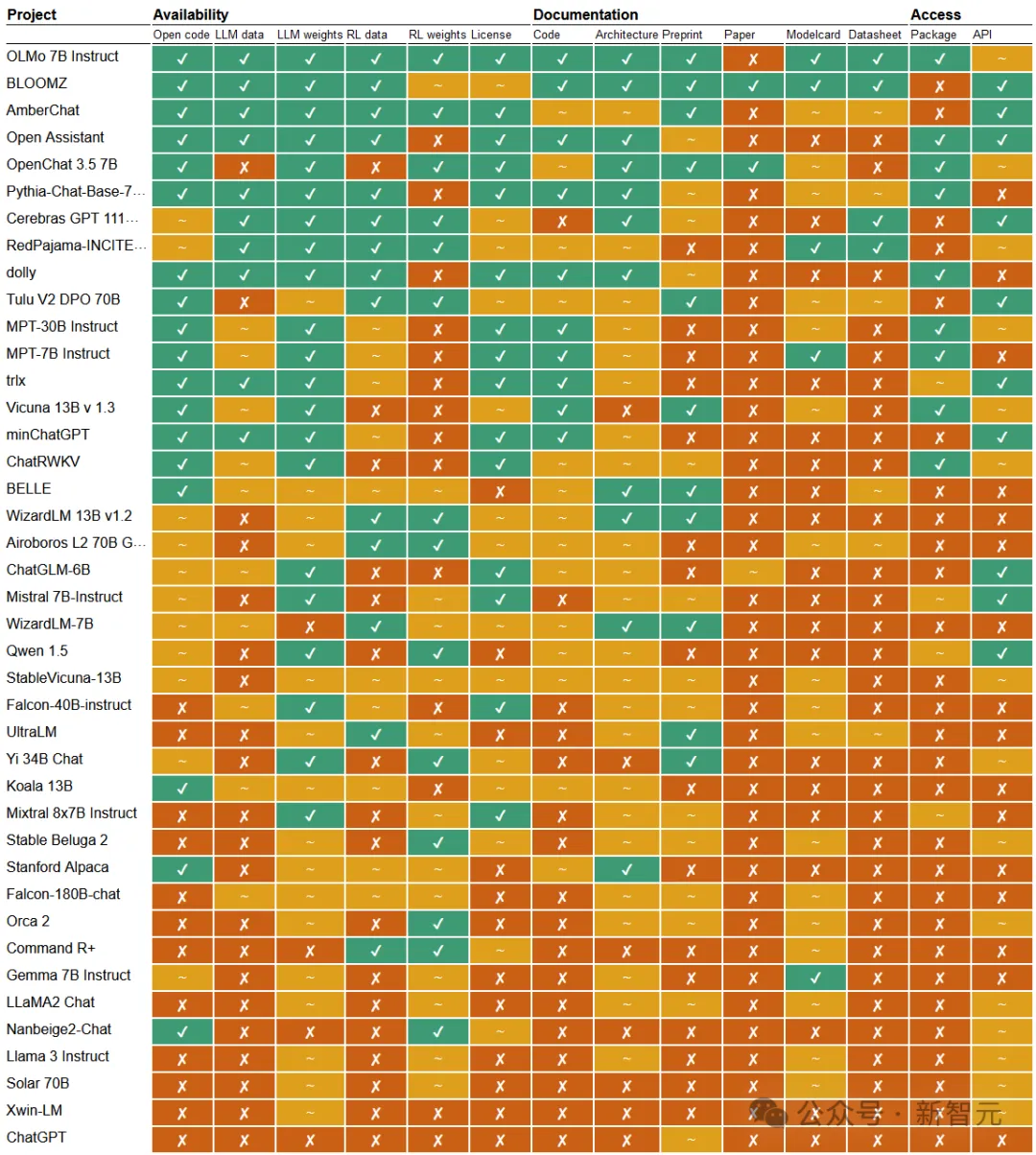

于是有了下面這種文本生成模型的開放性概覽圖,幾乎囊括了你能叫上來名字的所有模型。

可以看到,前十名中除了BLOOMZ和OLMo,幾乎沒有我們認(rèn)識(shí)的模型。這是因?yàn)檩^小的團(tuán)隊(duì)希望通過高標(biāo)準(zhǔn)的公開和透明,來彌補(bǔ)模型在規(guī)模和性能方面的不足。

Allen AI發(fā)布的OLMo系列以及BigScience的Bloom可以說是開源的典范,排在前兩名,接近完全開放的狀態(tài)。

這兩個(gè)模型的研發(fā)團(tuán)隊(duì)都在竭盡所能地提供訓(xùn)練數(shù)據(jù)、代碼、文檔和整個(gè)模型的pipeline。值得注意的是,Allen AI與Big Science都是非營(yíng)利機(jī)構(gòu)。

這種做法實(shí)在是少數(shù)中的少數(shù)。相比之下,三分之一的系統(tǒng)選擇只提供模型權(quán)重,但其他方面幾乎不公開任何細(xì)節(jié)

。

那么科技巨頭的表現(xiàn)如何呢?

ChatGPT無疑排名倒數(shù)第一,Cohere、谷歌、微軟等大型玩家都吊在車尾,包括被Meta包裝成開源模型的LLaMA。

在14個(gè)維度中,有兩項(xiàng)格外讓人擔(dān)憂:一是所有模型幾乎都沒有發(fā)布嚴(yán)謹(jǐn)?shù)摹⒔?jīng)過同行評(píng)審的論文,二是訓(xùn)練數(shù)據(jù)的整體不透明性。

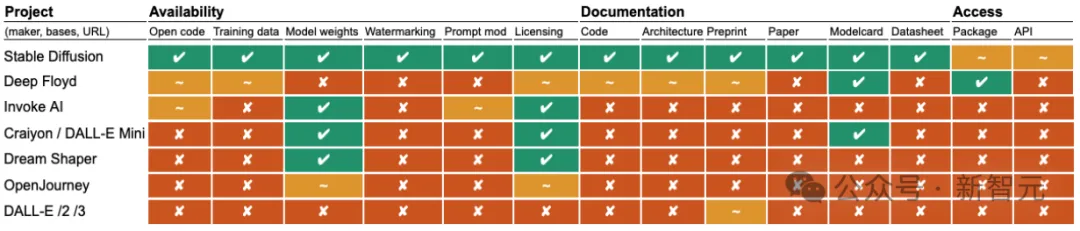

除了文本模型,論文也對(duì)文生圖模型進(jìn)行了評(píng)估。

在這個(gè)排行榜上,OpenAI的DALL-E倒數(shù)第一也在意料之內(nèi),但Stable Diffusion的表現(xiàn)尤為突出,也幾乎公開了所有信息,相比文本模型榜首的OLMo開放程度更高。

為什么論文只給概覽圖不給評(píng)分?是作者在水工作量嗎?

完全不是。對(duì)于「評(píng)分」這個(gè)問題,論文有進(jìn)一步的考量和闡述。

對(duì)同一個(gè)概覽圖結(jié)果,用不同的派生方法和權(quán)重,你就能得到不同的評(píng)分。

換言之,評(píng)分是可以被操縱的。

給所有維度分配相同的權(quán)重,并分別用1分、0.5分、0分賦給開放、部分開放、封閉三個(gè)結(jié)果,就能得到圖2中基于梯度測(cè)量的累積性分?jǐn)?shù)。

想要從分?jǐn)?shù)轉(zhuǎn)換成分類標(biāo)簽,可以設(shè)置不同的權(quán)重和閾值,用不同的方法劃分評(píng)分空間就會(huì)得到不同的結(jié)果,比如圖3和圖4。

我們目前所面臨的現(xiàn)實(shí),更加接近上面圖5中的情況,也就是讓唯一的指標(biāo)「一葉障目」,只通過是否有開放許可證或者是否公開了模型權(quán)重,判斷系統(tǒng)的開放性。

安全AGI,需要不盲目的開放

應(yīng)不應(yīng)該開放?對(duì)這個(gè)頗有爭(zhēng)議的問題,作者在論文最后給出了自己的觀點(diǎn)。

在完全共享模型每個(gè)組件和所有數(shù)據(jù)的「激進(jìn)式開放」,和被稀釋到極其微弱的「順勢(shì)療法開放」(如只公開模型權(quán)重)之間,還存在著許多條道路。

完全開放并不是最完美的解決方案,比如AI的不正當(dāng)使用、有害數(shù)據(jù)的泄露,都是不能忽視的問題。

開放性有不同的程度和維度,對(duì)生成式AI的監(jiān)管應(yīng)該鼓勵(lì)有意義的開放。比如訓(xùn)練和微調(diào)數(shù)據(jù),有可能在公眾審查和專業(yè)審核的目光下變得更加安全。

但是,在大多數(shù)情況下,開放依舊要好過封閉,這對(duì)于系統(tǒng)的風(fēng)險(xiǎn)分析(公眾需要知道)、可審查性(評(píng)估人員需要知道)、科學(xué)可復(fù)現(xiàn)性(科研工作者需要知道)以及法律責(zé)任(用戶需要知道)都有重要意義。

對(duì)評(píng)估人員而言,設(shè)計(jì)更好的評(píng)估框架,得出有意義、基于證據(jù)、多維度的開放性判斷,避免被操縱、偏頗的指標(biāo),能夠幫助我們做出更好的決定。

本文轉(zhuǎn)自 新智元 ,作者:新智元