直播首秀 AI大模型的存儲(chǔ)之道 原創(chuàng)

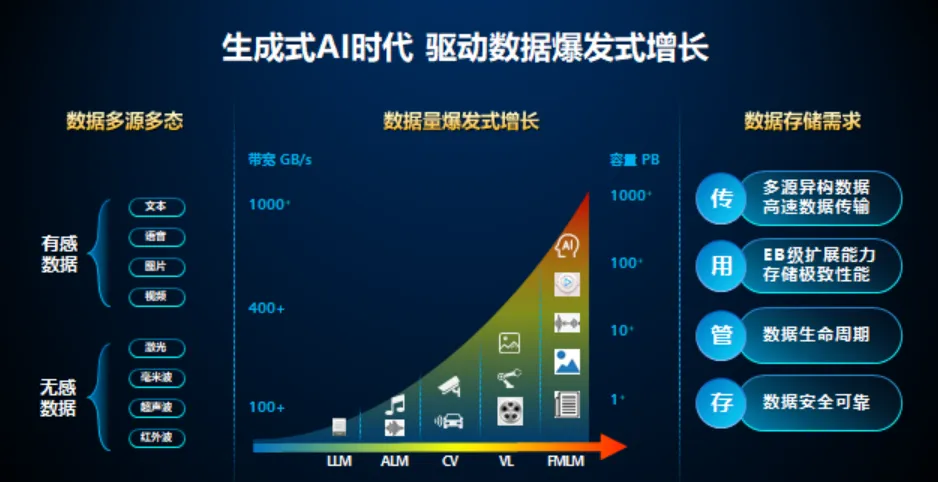

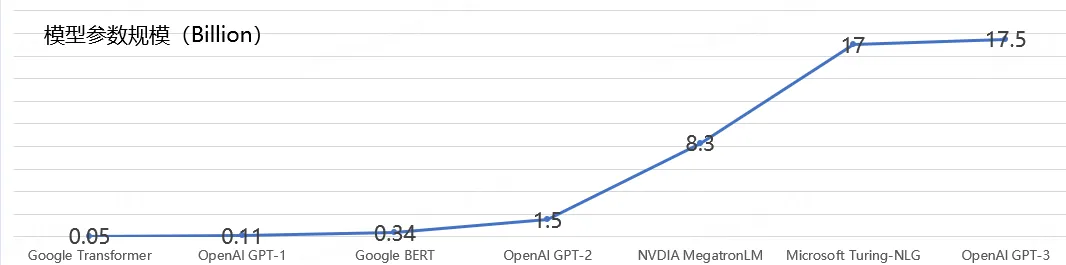

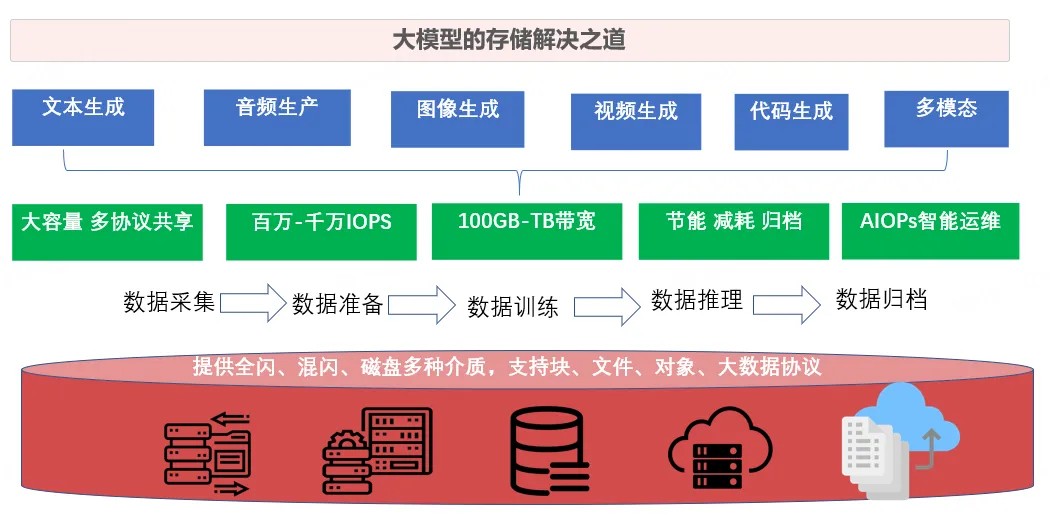

AIGC 在 2023 年爆火,各類大模型層出不窮,參數(shù)動(dòng)輒達(dá)到千億數(shù)量級。這些背后,數(shù)據(jù)的類型和形式也走向復(fù)雜多樣。例如大模型會(huì)采用到我們真實(shí)物理世界中的文字、視覺、音頻、3D、雷達(dá)、多譜等復(fù)雜多樣的不同模態(tài)信號和數(shù)據(jù),數(shù)據(jù)則又存在結(jié)構(gòu)化、半結(jié)構(gòu)化、非結(jié)構(gòu)化等多種形式。

在大模型發(fā)展的初期:GPU很貴,相比之下存儲(chǔ)的成本忽略不計(jì),可以直接選性能最好最貴的存儲(chǔ)方案。典型的高性能文件系統(tǒng)有GPFS、Lustre、Weka,以及其他高性能NAS 等。這些系統(tǒng)通常依賴全閃存(NVMe) 和高性能網(wǎng)絡(luò)提供極致性能。

但是隨著算力、數(shù)據(jù)與團(tuán)隊(duì)投入都增大的時(shí)候,又發(fā)現(xiàn)新的問題:在預(yù)訓(xùn)練階段,會(huì)產(chǎn)生更多實(shí)驗(yàn)結(jié)果和中間數(shù)據(jù),加上各種模型的checkpoint 和日志數(shù)據(jù),預(yù)訓(xùn)練環(huán)節(jié)總數(shù)據(jù)量預(yù)計(jì)將達(dá)到10PB 到 100PB。正式訓(xùn)練環(huán)節(jié),雖然企業(yè)可以將全部數(shù)據(jù)存儲(chǔ)于高性能存儲(chǔ)系統(tǒng)中,但是,高性能文件系統(tǒng)的性能都與容量是關(guān)聯(lián)的。如果要達(dá)到訓(xùn)練所需的I/O 性能,需要擴(kuò)大高性能文件系統(tǒng)容量。

大模型背景下,“存力”成為關(guān)鍵基礎(chǔ)設(shè)施能力。2023年10月,工業(yè)和信息化部等6部門聯(lián)合印發(fā)了《算力基礎(chǔ)設(shè)施高質(zhì)量發(fā)展行動(dòng)計(jì)劃》,明確提出到2025年存儲(chǔ)總量超過 180EB 、先進(jìn)存儲(chǔ)容量占比達(dá)30% 以上的目標(biāo)。先進(jìn)存儲(chǔ)是指應(yīng)用全閃存陣列、SSD 等先進(jìn)存儲(chǔ)部件,采用存算分離、高密等先進(jìn)技術(shù),單位容量數(shù)據(jù)操作能力達(dá)到萬 IOPS(每秒讀寫次數(shù))以上的存儲(chǔ)模塊。

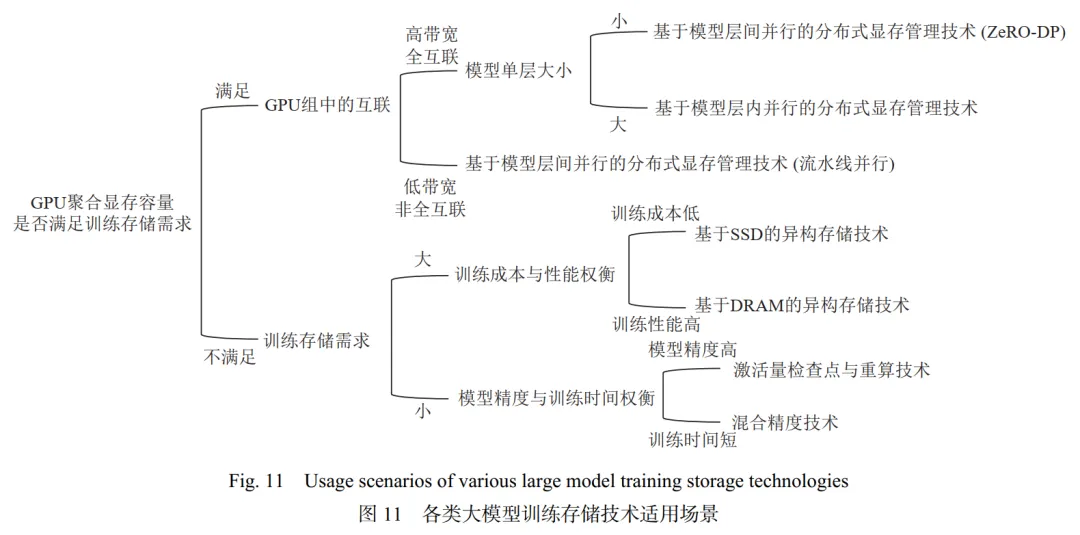

下圖展示了根據(jù)算法性能需求和所用硬件條件選擇最合適的存儲(chǔ)技術(shù)的流程。在實(shí)際訓(xùn)練過程中,可能會(huì)混合采用多種不同的存儲(chǔ)技術(shù)。例如,在GPU集群中,通過高帶寬的NVLink互聯(lián)的GPU組使用基于層內(nèi)并行的分布式顯存管理技術(shù);通過帶寬較低的PCIe互聯(lián)的GPU組使用流水線并行的方式。

大模型場景對于存力有著高吞吐、高IOPS、高帶寬、低延時(shí)的極致性能要求。尤其是大模型訓(xùn)練環(huán)節(jié),其數(shù)據(jù)量大、參數(shù)規(guī)模大、訓(xùn)練周期長、投資規(guī)模大等特點(diǎn)是傳統(tǒng)AI場景所不具備的,因此為傳統(tǒng)AI場景而構(gòu)建的基于開源技術(shù)或商業(yè)化產(chǎn)品的存力難以滿足性能需求。那什么樣的存儲(chǔ)架構(gòu)才是AI大模型時(shí)代的最佳選擇呢?

首先,可以指定數(shù)據(jù)首次寫入時(shí)的放置策略,例如在數(shù)據(jù)獲取階段,新獲取的數(shù)據(jù)需要在短時(shí)間內(nèi)處理的,可以直接放置到高性能層;而新獲取的數(shù)據(jù)在短時(shí)間內(nèi)無需處理的或用來長期歸檔的數(shù)據(jù),則可以直接寫入容量層;其次,可以設(shè)置豐富的數(shù)據(jù)分級流動(dòng)策略,例如可以設(shè)置訪問頻度與時(shí)間相結(jié)合的流動(dòng)策略,也可以設(shè)置容量水位觸發(fā)的流動(dòng)策略;再者,根據(jù)用戶制定的分級策略,數(shù)據(jù)能夠在高性能層和大容量層之間自動(dòng)分級流動(dòng),數(shù)據(jù)分級遷移過程對業(yè)務(wù)應(yīng)用完全透明;最后,對于已經(jīng)分級到容量層的數(shù)據(jù),用戶可以通過命令或API對指定的數(shù)據(jù)集配置預(yù)熱策略,以加速計(jì)劃性任務(wù)的冷啟動(dòng)速度。

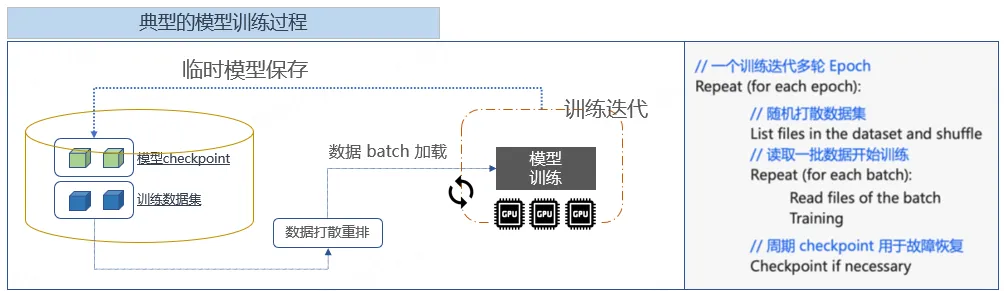

大模型訓(xùn)練中的檢查點(diǎn)Checkpoint

GPU 故障數(shù)量隨著 GPU 集群規(guī)模的增大而提高。GPU 的頻繁故障一方面會(huì)導(dǎo)致訓(xùn)練得到的參數(shù)丟失;另一方由于大模型訓(xùn)練中各 GPU 間的數(shù)據(jù)存在依賴關(guān)系,單 GPU 的故障會(huì)擴(kuò)散到整個(gè) GPU 集群中,有 2 類主要的工作解決大模型訓(xùn)練故障的問題:參數(shù)檢查點(diǎn)和冗余計(jì)算。

參數(shù)檢查點(diǎn)技術(shù)以設(shè)定的頻率,將訓(xùn)練得到的參數(shù)信息存儲(chǔ)到持久化的存儲(chǔ)介質(zhì)中,以對 GPU 故障進(jìn)行容錯(cuò)。在 GPU 故障后,參數(shù)檢查點(diǎn)技術(shù)利用最新且完整的參數(shù)進(jìn)行恢復(fù)。參數(shù)檢查點(diǎn)技術(shù)需要大容量的持久化存儲(chǔ)設(shè)備以保存檢查點(diǎn)信息。并且在恢復(fù)階段,參數(shù)檢查點(diǎn)需要從持久化介質(zhì)中讀取之前版本的參數(shù),這導(dǎo)致恢復(fù)開銷高,利用冗余計(jì)算的方式,在多張 GPU 中重復(fù)計(jì)算相同版本的參數(shù),以對模型訓(xùn)練數(shù)據(jù)容錯(cuò)。在這個(gè)過程中,存儲(chǔ)要能在AI訓(xùn)練每個(gè)epoch的shuffle階段,提供高效的億級文件列表獲取能力;要能支撐住在上億訓(xùn)練集文件上,通過為每個(gè)文件頻繁創(chuàng)建新的硬鏈接,以實(shí)現(xiàn)訓(xùn)練集的版本管理能力。

數(shù)據(jù)總量和數(shù)據(jù)質(zhì)量決定了AI大模型的高度,數(shù)據(jù)準(zhǔn)備效率和數(shù)據(jù)在全流程間的流轉(zhuǎn)效率將成為影響AI大模型端到端生產(chǎn)成本的核心要素。選擇一套可以滿足AI大模型快速發(fā)展的存儲(chǔ)系統(tǒng),對于提升大模型生產(chǎn)效率、降低大模型TCO至關(guān)重要。

大模型訓(xùn)練場景的基礎(chǔ)設(shè)施,618直播間討論。

Q1:說起AI大模型,我們首先聯(lián)想到的是GPU,算力,英偉達(dá)。有這些就夠了嗎?

A1:顯然不是,英偉達(dá)股價(jià)一路上漲,確實(shí)會(huì)讓人有個(gè)錯(cuò)覺,AI就是GPU,其實(shí)不是,網(wǎng)上有句戲言:挖金子的AI還在虧,賣鏟子卻賺翻了。如果把數(shù)據(jù)當(dāng)成一個(gè)礦藏,GPU好比挖礦的鏟子一樣。大模型訓(xùn)練除了需要GPU算力,存力也是AI大模型的重要保障,主要基于以下幾個(gè)因素。

1,先說參數(shù)。ChatGPT 3.5發(fā)布的時(shí)候1750億參數(shù),火星人埃隆馬斯克發(fā)布的Grok-1是3140 億參數(shù),源文件200G,運(yùn)行起來就得700G顯存。未來大模型參數(shù)千億級別奔向萬億參數(shù);

2,再說數(shù)據(jù)集。大模型已從單模態(tài)走向多模態(tài),將來還會(huì)走向全模態(tài);用于訓(xùn)練的數(shù)據(jù)集從3TB,增長到多模態(tài)40TB,未來全模態(tài)將會(huì)達(dá)到PB級數(shù)據(jù);

3,對算力需求的增長速度大幅超越單GPU卡算力的增長速度,大模型訓(xùn)練集群的規(guī)模會(huì)變得越來越大,這樣才能保證大模型的涌現(xiàn)能力;模型訓(xùn)練checkpoint數(shù)據(jù)量也從十幾GB增長到幾百個(gè)GB,檢查點(diǎn)保存和恢復(fù)進(jìn)度與模型大小成正比,更高頻度的CheckPoint給存儲(chǔ)帶來巨大寫入帶寬挑戰(zhàn)。

Q2:你剛才說到一個(gè)詞,涌現(xiàn)能力這個(gè)詞怎么理解?

A2:涌現(xiàn) 字面理解,厚積薄發(fā)。什么是“涌現(xiàn)現(xiàn)象”?當(dāng)一個(gè)復(fù)雜系統(tǒng)由很多微小個(gè)體構(gòu)成,這些微小個(gè)體湊到一起,相互作用,當(dāng)數(shù)量足夠多時(shí),在宏觀層面上展現(xiàn)出現(xiàn)象,就可以稱之為“涌現(xiàn)現(xiàn)象”。在日常生活中也有一些涌現(xiàn),譬如雪花,雪花的構(gòu)成是水分子,水分子很小,但是大量的水分子如果在外界溫度條件變化的前提下,相互作用,在宏觀層面就會(huì)形成一個(gè)很規(guī)律、很對稱、很美麗的雪花。

在AI大模型訓(xùn)練過程中,人工智能模型有時(shí),似乎會(huì)突然「理解」一個(gè)問題,盡管它們只是記住了訓(xùn)練數(shù)據(jù)。這個(gè)突然轉(zhuǎn)變的過程,有個(gè)形象的說法叫頓悟,大模型突然從簡單地復(fù)制訓(xùn)練數(shù)據(jù),轉(zhuǎn)變?yōu)榘l(fā)現(xiàn)可推廣的解決方案。

AI大模型擁有更強(qiáng)的涌現(xiàn)能力,才會(huì)擁有更精準(zhǔn)的語言理解和推理能力。當(dāng)然,這里有一個(gè)重要的前提是,足夠多數(shù)據(jù)集對大模型進(jìn)行高效訓(xùn)練和存儲(chǔ)調(diào)度。否則的話,就算是有愛因斯坦的大腦,不識(shí)字不讀書,那也很難進(jìn)行創(chuàng)造性的思考。

Q3:那也就說,不管你有多少GPU,但沒有足夠多的數(shù)據(jù)集訓(xùn)練和存儲(chǔ)調(diào)度,也是無法頓悟?

A3:是的,頓悟是模型涌向能力的形象說法,該能力無處不在,只要摸清條件,做好AI全流程的數(shù)據(jù)存儲(chǔ)和資源調(diào)度,大模型就會(huì)頓悟,只是早晚的事。

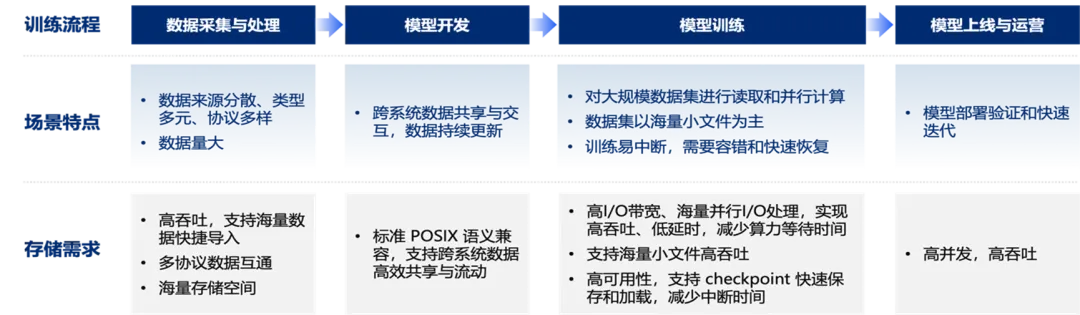

AI全流程包括數(shù)據(jù)獲取、數(shù)據(jù)預(yù)處理、模型訓(xùn)練與評估、模型部署應(yīng)用這四個(gè)階段,每個(gè)階段都涉及海量數(shù)據(jù)的存儲(chǔ)與訪問。大模型的存儲(chǔ)系統(tǒng)應(yīng)該是什么樣子呢?

這套存儲(chǔ)系統(tǒng)需要同時(shí)具備高性能層和大容量層,并對外呈現(xiàn)統(tǒng)一的命名空間,具備數(shù)據(jù)全生命周期管理的能力。同時(shí),這套存儲(chǔ)還得可以承載AI全流程業(yè)務(wù),支持NAS、大數(shù)據(jù)、對象、并行客戶端等多種訪問傳輸協(xié)議。而且呢,這套存儲(chǔ)還得具備數(shù)千節(jié)點(diǎn)的橫向擴(kuò)展能力,隨著存儲(chǔ)節(jié)點(diǎn)數(shù)的增加,系統(tǒng)帶寬和元數(shù)據(jù)訪問能力可實(shí)現(xiàn)線性增長。這些需求,傳統(tǒng)的存儲(chǔ),無論是集中式還是分布式,都是無法有效滿足大模型訓(xùn)練的特殊應(yīng)用場景。

Q4:在大模型場景中,京東云海是否具備以上特點(diǎn)?

A4:京東云海是京東云的存儲(chǔ)底座,利用完全自研的統(tǒng)一存儲(chǔ)引擎,提供塊文件 對象 并行 分布式 大數(shù)據(jù)等五種協(xié)議訪問,所有需要高效處理的數(shù)據(jù) 均在高性能存儲(chǔ)層完成,AI全流程各階段協(xié)同時(shí),不再需要頻繁遷移數(shù)據(jù)。

京東云海可以大幅提升AI大數(shù)據(jù)訓(xùn)練數(shù)據(jù)準(zhǔn)備效率,提高AI計(jì)算集群的GPU利用率,顯著降低算力投資成本 和數(shù)據(jù)預(yù)處理成本,大大縮短AI大模型開發(fā)的周期。生產(chǎn)一個(gè)千億級參數(shù)的大模型端到端TCO總體擁有成本可以降低10%以上。

Q5:如此說來,京東云海確實(shí)是一款大模型訓(xùn)練必備產(chǎn)品,怎么才能稱得上好呢?

A5:京東云海一套系統(tǒng)、一套參數(shù)具備高性能動(dòng)態(tài)混合負(fù)載的承載能力。這該怎么理解呢?

在數(shù)據(jù)導(dǎo)入階段,大小文件同時(shí)寫入;在數(shù)據(jù)預(yù)處理階段,大小文件批量讀取處理后生成海量小文件;在模型訓(xùn)練階段,海量小文件批量隨機(jī)讀取;在生成CheckPoint時(shí),要能滿足大高帶寬寫入;在模型部署階段,即使大并發(fā)讀取同一個(gè)模型文件,隨著部署設(shè)備數(shù)量的增加,集群聚合吞吐帶寬仍然可以線性增長。譬如,千億級大模型產(chǎn)生的模型文件有 400 GB 左右,向業(yè)務(wù)推送時(shí),需要并發(fā)分發(fā)到前端數(shù)千個(gè)業(yè)務(wù)實(shí)例上。分發(fā)過程涉及 數(shù)百TB數(shù)據(jù)的讀取,因此需要高并發(fā)大帶寬讀取分發(fā)能力。

再說到一款好的產(chǎn)品是怎么樣的?必然是成本更低 性能更優(yōu)和穩(wěn)定可靠三項(xiàng)特征的集合,而京東云海,就是這三者合一的最佳之選。還有很關(guān)鍵的一點(diǎn)是,交付方式十分靈活,可以是通過純軟件授權(quán),軟硬件一體機(jī)和系統(tǒng)集成的方式交付。

截止目前除了互聯(lián)網(wǎng)電商場景外,在一些大的算力中心,銀行證券醫(yī)療等行業(yè)已有落地案例。

本文轉(zhuǎn)載自公眾號數(shù)字化助推器 作者:天涯咫尺TGH