AI畫連環(huán)畫角色更一致了!人物之間的復(fù)雜互動也能處理|中山大學(xué)&聯(lián)想團(tuán)隊出品

讓AI畫漫畫角色保持一致的新研究來了!

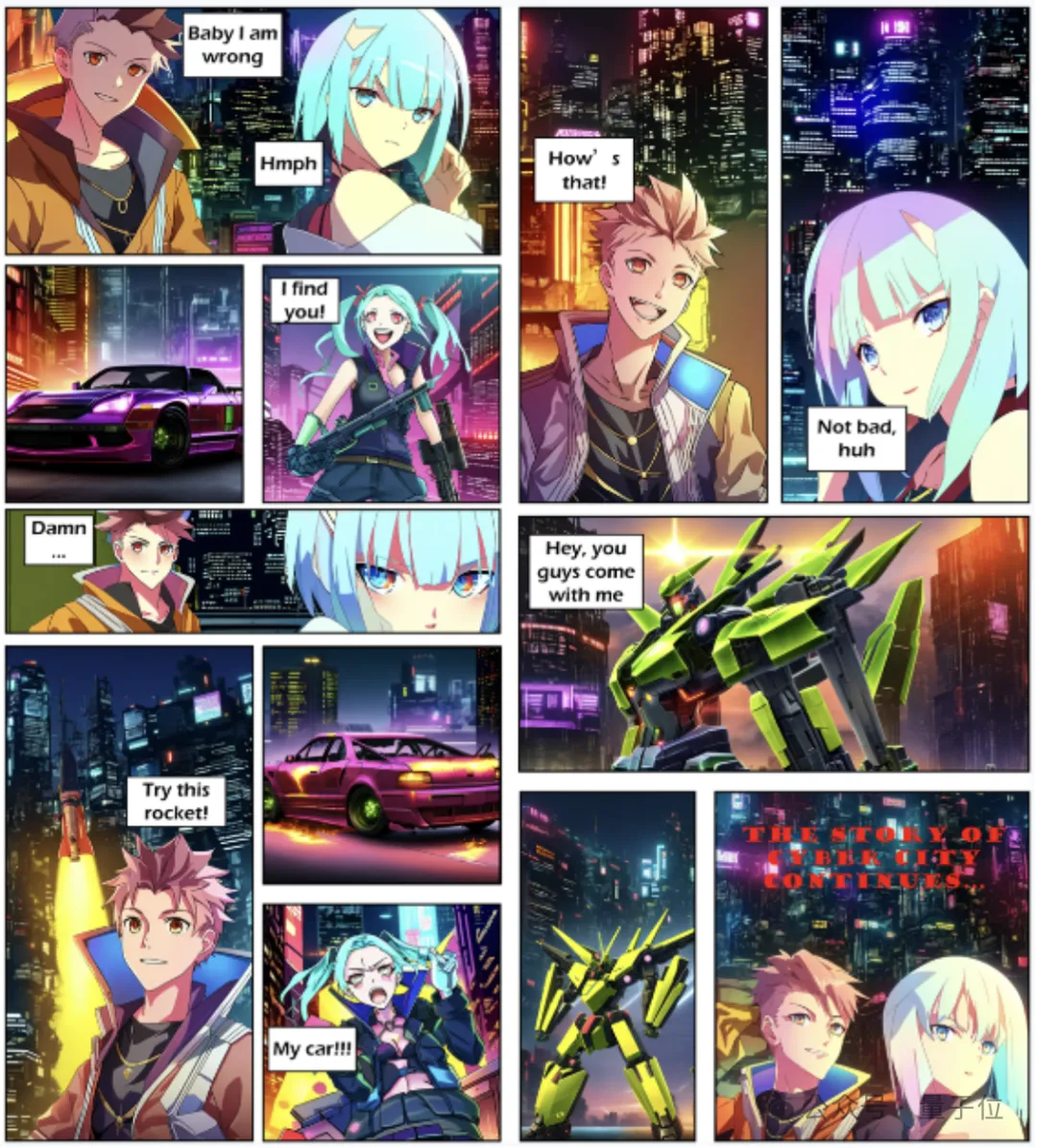

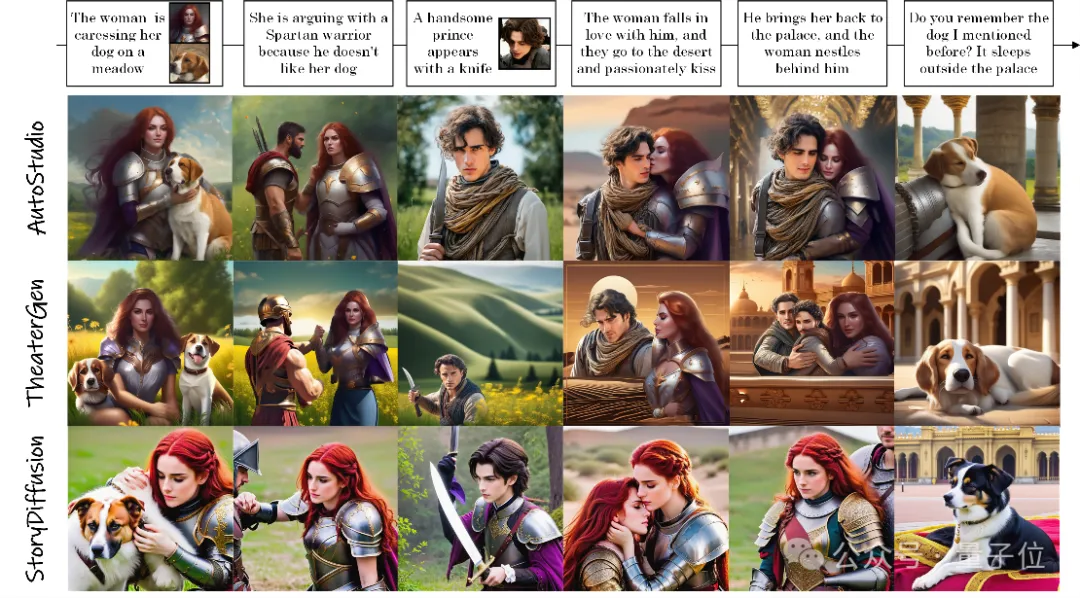

創(chuàng)作的連環(huán)畫效果belike:

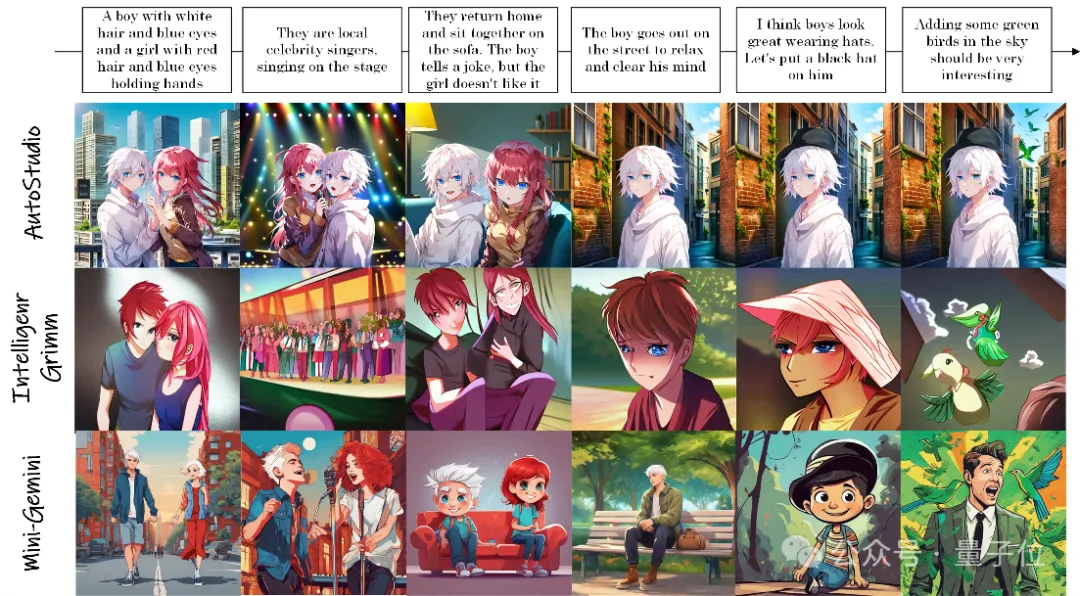

頻繁切換主體、人物之間復(fù)雜的互動也能保持角色一致性:

上述效果來自AutoStudio,是一個由中山大學(xué)和聯(lián)想團(tuán)隊聯(lián)合提出的無需訓(xùn)練的多智能體協(xié)同框架。

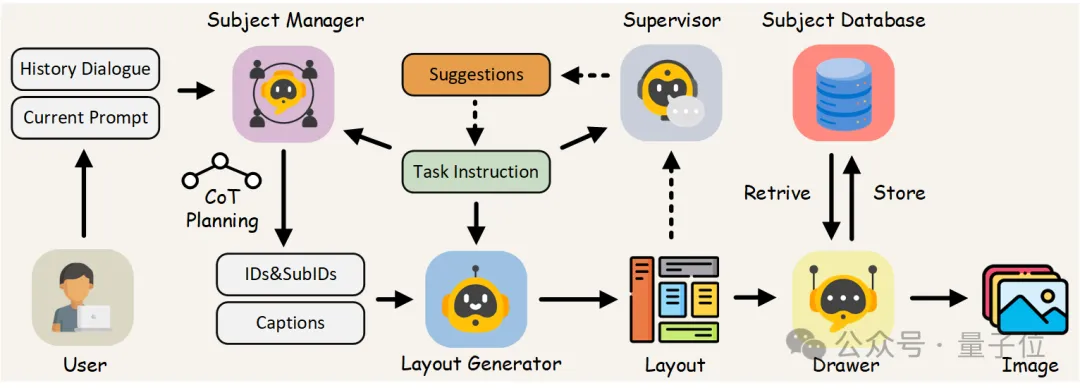

AutoStudio采用基于大?語言模型的三個智能體來處理交互,并使用基于擴(kuò)散模型的Drawer生成高質(zhì)量圖像。

實驗中,AutoStudio無論是在定量還是定性評估中都優(yōu)于現(xiàn)有方法。

AutoStudio長啥樣?

由于最先進(jìn)的?T2I?生成模型在生成令人印象深刻的單個圖像方面表現(xiàn)出了卓越的能力,研究界對更復(fù)雜的多輪交互式圖像生成工作的興趣與日俱增。

在現(xiàn)實世界的應(yīng)用中,用戶經(jīng)常需要以交互方式生成一系列圖像,其中包括各種任務(wù),如開放式故事生成和多主體多輪編輯。

然而,目前的方法大多數(shù)要求預(yù)先定義所有輪的生成指令,并且在面對不同的用戶指令(如定制、編輯和大量交叉引用)時,很難在多個主體之間保持一致性。

為了解決這些問題,研究團(tuán)隊引入了AutoStudio,這是一個多智能體?、無需訓(xùn)練的框架,具有四個特別定制的智能體,利用現(xiàn)成的模型與用戶進(jìn)行即時交互。

他們的目標(biāo)是引入一個多功能、可擴(kuò)展的框架,通過多智能體協(xié)作,可以將任何所需的LLM架構(gòu)和擴(kuò)散骨干結(jié)合到框架中,以滿足用戶多輪生成的多樣化需求。

具體而言,AutoStudio包括三個基于LLM的智能體:

- 主題管理器解釋對話,識別不同的主題,并為其分配適當(dāng)?shù)纳舷挛模?/li>

- 布局生成器為每個主題生成部分級別的邊界框,以控制主題的位置;

- 監(jiān)督員為布局生成器提供布局改進(jìn)和修正的建議。

最后,繪制器基于擴(kuò)散模型完成基于改進(jìn)布局的圖像生成。

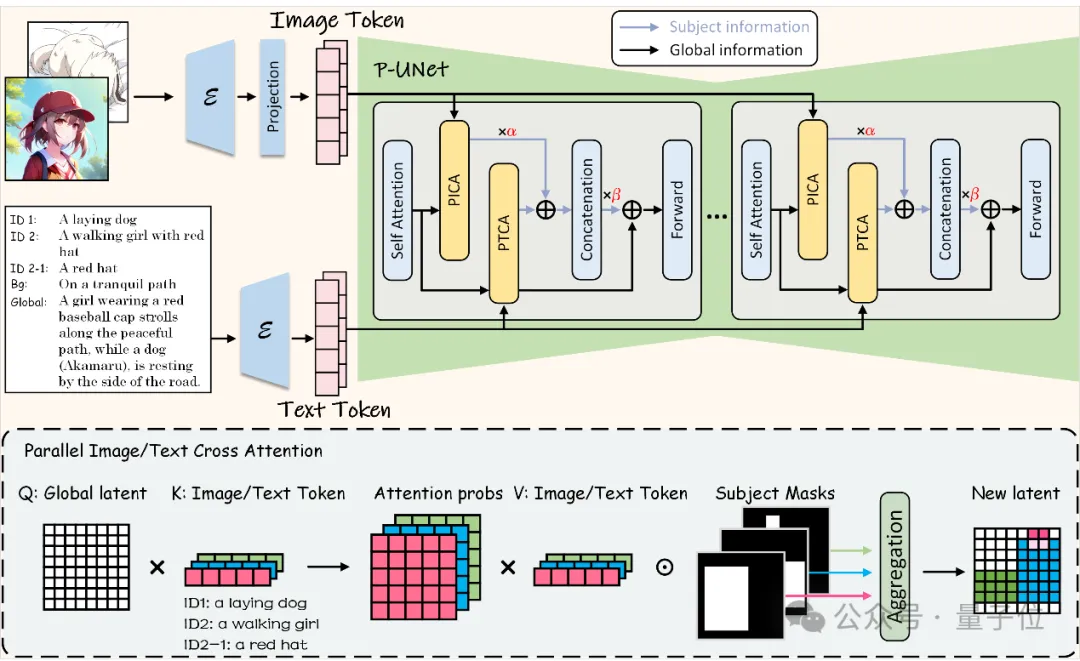

此外,研究人員在繪制器中引入了一個并行UNet(P-UNet),它具有一種新穎的架構(gòu),利用兩個并行的交叉注意力模塊分別增強(qiáng)文本和圖像嵌入的潛在主題特征。

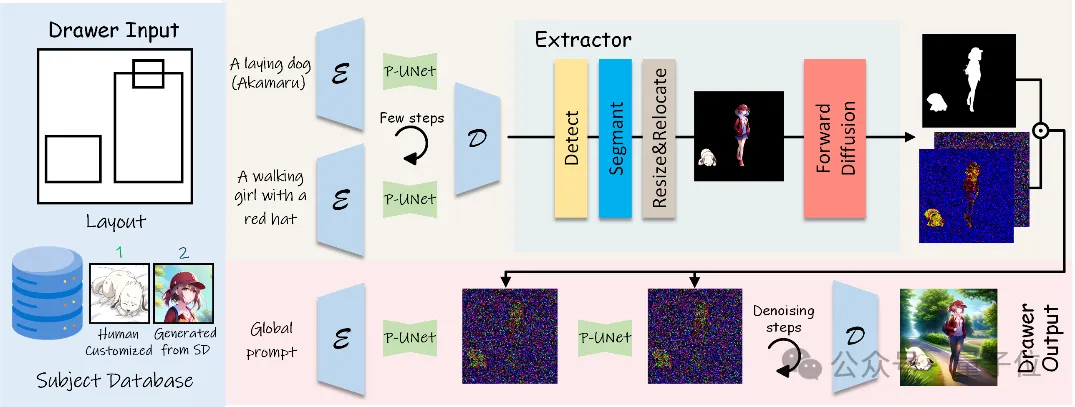

為了進(jìn)一步解決SD在理解長提示和生成過程中缺失和錯誤融合主題的限制,研究人員在繪制器中引入了一種主題初始化的生成方法。

接下來是對AutoStudio架構(gòu)的詳細(xì)說明。

多智能體協(xié)同

研究團(tuán)隊首先引入一個主題管理器Manager,它不僅能為主題及其組件分配ID,還能將用戶提示轉(zhuǎn)換為繪圖說明。

然后,布局生成器Layout Generator對這些標(biāo)題進(jìn)行處理,生成粗略的布局,其中包含每個主題及其組件的邊界框和信息。

為了糾正不合理的主體內(nèi)和主體間空間關(guān)系并完善粗略布局,引入了一個監(jiān)督器Supervisor。

該監(jiān)督器將粗布局作為輸入,并向布局生成器提供建議。

通過這種方式,Supervisor和Layout Generator密切協(xié)作,形成一個布局細(xì)化的閉環(huán)流程。

此外,研究團(tuán)隊還定義了一組任務(wù)介紹,以指導(dǎo)這三個基于 LLM 的代理生成格式正確的響應(yīng)。

最后,給定細(xì)化布局和從主體庫中獲取的主體信息,繪圖器Drawer?可以生成與布局對齊且包含一致主體的圖像。

主體初始化生成過程

為了解決多ID綁定任務(wù)中主體丟失和融合的問題,研究人員引入主體初始化生成過程。

這個過程包括對主體粗粒度特征的單獨生成,使用提取器提取特征并通過正向擴(kuò)散映射到潛空間并在全局生成的初始幾步進(jìn)行局部替換。

P-UNet

Stable Diffusion模型中的原始UNet利用交叉注意模塊來利用文本特征,但這不足以表示多個主體的空間關(guān)系和特征。

因此,研究人員提出了利用免訓(xùn)練布局調(diào)整注意力模塊的P-UNet。

將UNet層的原始交叉注意模塊拆分為兩個并行的文本和圖像交叉注意模塊(分別稱為PTCA和PICA)來細(xì)化Z,這兩個模塊具有相同的架構(gòu),其主要思想是計算Z與每個主體文本/圖像嵌入之間的特征相似性。

AutoStudio效果如何?

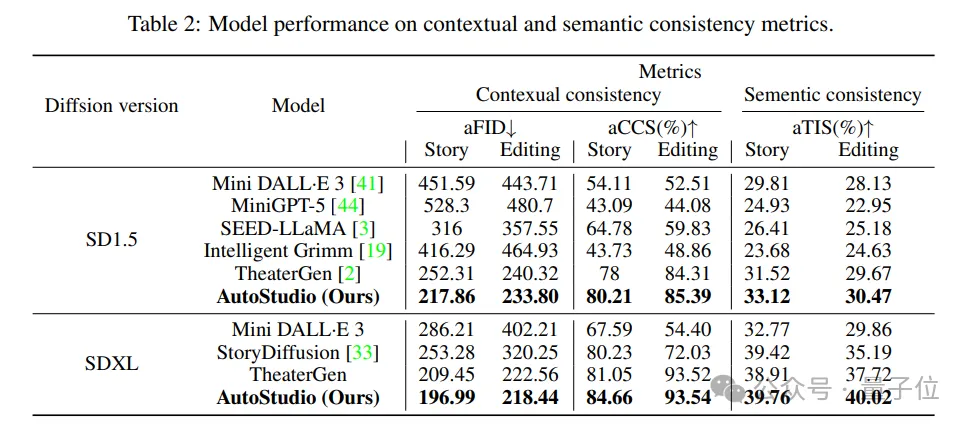

研究人員在CMIGBench上利用所選的基準(zhǔn)模型對AutoStudio進(jìn)行了全面評估。

CMIGBench基于故事生成和多輪編輯,包含8000個多輪腳本對話(每個任務(wù)4000個)。

研究人員選擇了平均弗雷謝特起始距離(aFID)和平均字符-字符相似度(aCCS)這兩個定量指標(biāo)來評估上下文一致性,并選擇了平均文本-圖像相似度(aTIS)來評估主體間的語義一致性。

結(jié)果,AutoStudio在所有指標(biāo)上都明顯優(yōu)于之前的方法。

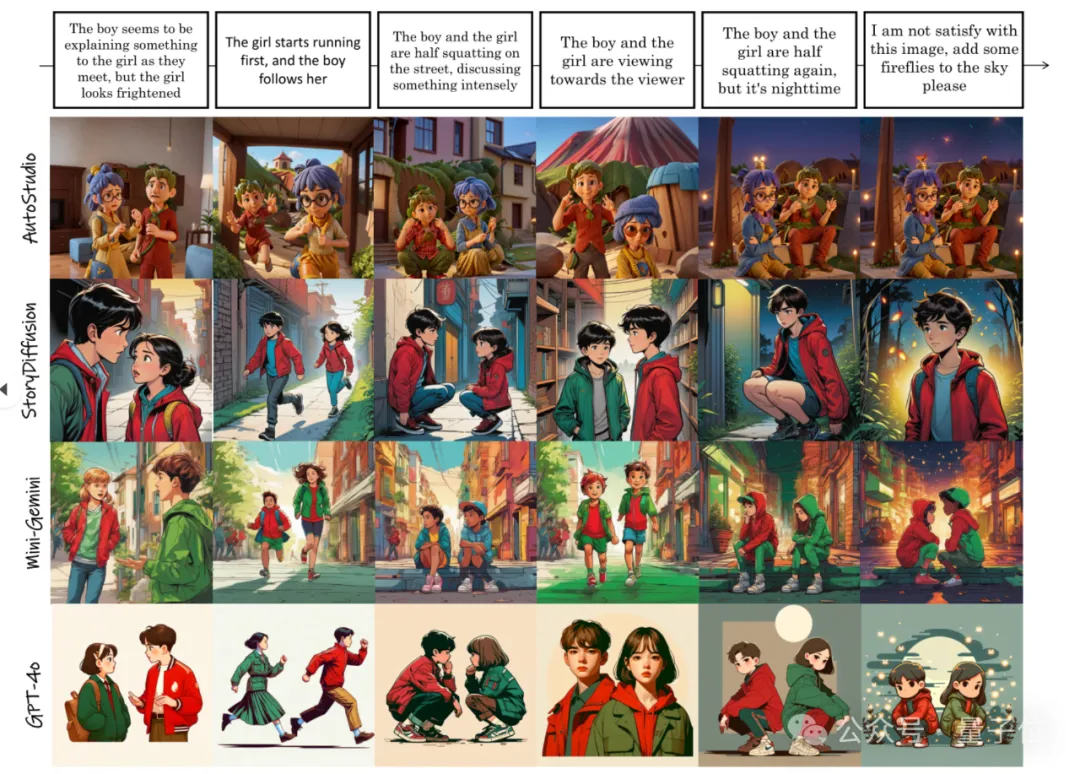

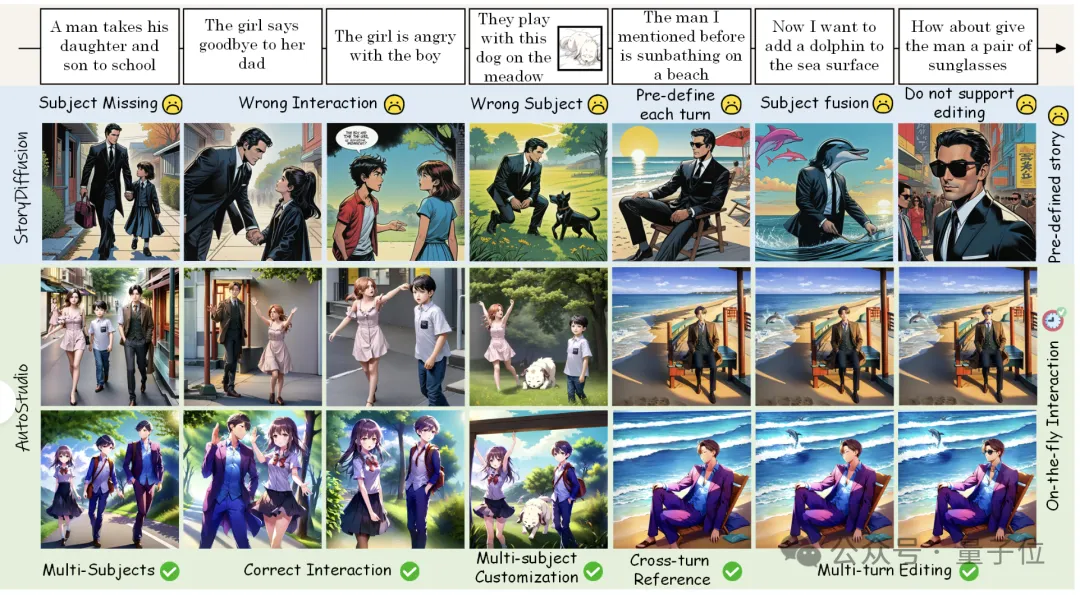

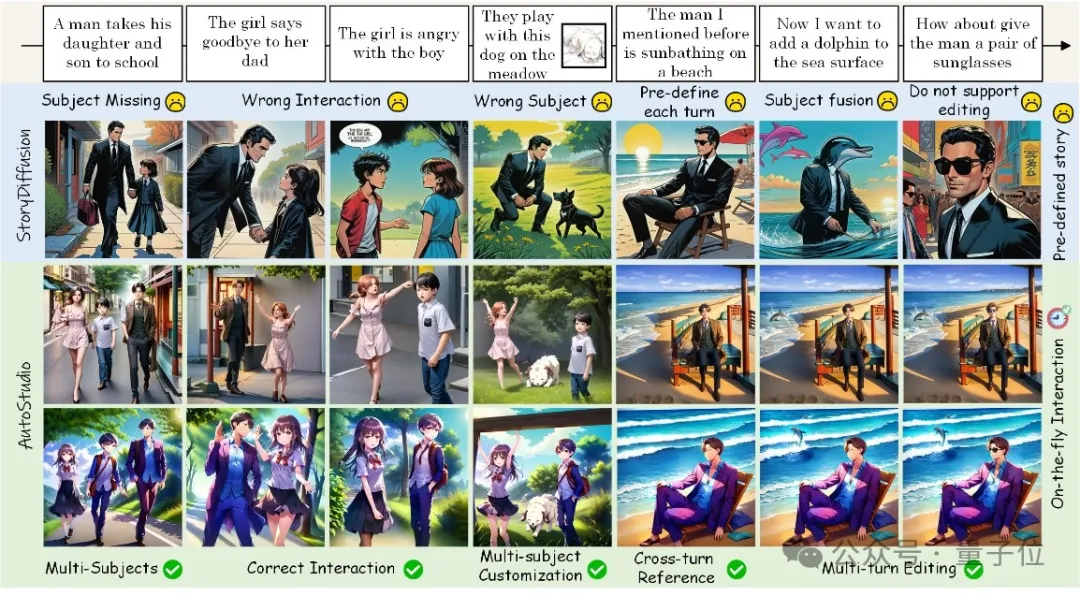

下圖展示了多輪交互式圖像生成的可視化結(jié)果,表明AutoStudio能夠理解用戶的自然語言指令,并生成主題一致的圖像。

相比而言,Theatergen無法處理人物之間復(fù)雜的互動(如擁抱和接吻),而MiniGemini則難以保持主體的一致性。

Intelligent Grimm和StoryDiffusion無法在多回合互動中保持多個角色之間的一致性,并表現(xiàn)出有限的編輯效果。

論文鏈接:https://arxiv.org/abs/2406.01388

項目主頁:https://howe183.github.io/AutoStudio.io/

本文轉(zhuǎn)自量子位 ,作者:量子位