「汪汪」to Vector!密歇根博士生用AI解碼狗的聲音 | LREC 2024 精華

有沒有想過你的狗狗想要對你說什么?

在科幻或者想象的場景中,人類有時會編織類似的情節。

然而在AI風行之下,科幻已然到來!

狗的語言也是「自然語言」,人的語言能word to vector,「汪汪」為什么不行?

近日,就有研究人員開發了一款人工智能工具,可以區分不同含義的狗叫聲,并識別狗的年齡、性別和品種。

論文地址:?https://arxiv.org/pdf/2404.18739??

而且,研究結果表明,源自人類語音的聲音和模式,可以作為分析和理解其他聲音(例如動物發聲)聲學模式的基礎。

研究者來自密歇根大學,以及墨西哥國家天體物理、光學和電子研究所(INAOE)。

該篇工作同時發表在International Conference on Computational Linguistics, Language Resources and Evaluation上。

這是一作Artem Abzaliev,和他的狗Nova:

——以前是遇事不決,量子力學,以后搞不定的事都喂給AI模型就行了。

大模型:嗯?怎么今天的飯味道怪怪的?

要理解狗狗,首先需要收集狗狗的數據,二作Humberto Pérez-Espinosa負責領導收集數據的團隊,共記錄了74只不同品種、年齡和性別的狗狗在各種情況下發出的聲音。

然后是訓練模型,研究人員比較了兩種方式的實現效果:

1. 完全用狗狗的聲音數據從頭訓練模型;

2. 在人類語音預訓練模型的基礎上,使用狗狗聲音數據進行微調。

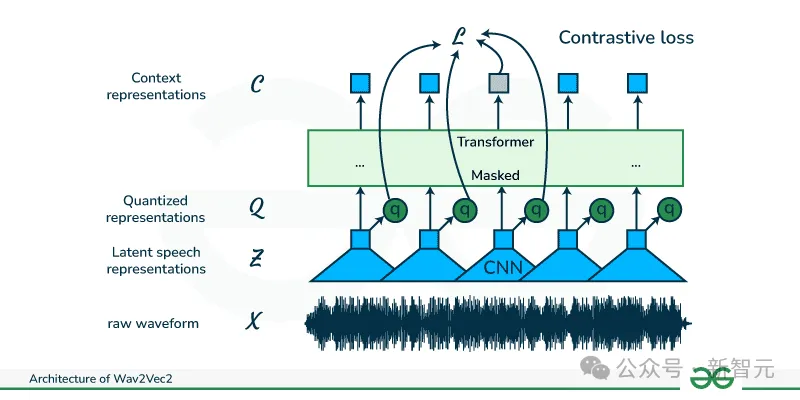

模型選擇Wav2Vec2,是使用人類語音數據訓練的SOTA語音表示模型。

通過這個模型,研究人員能夠生成從狗身上收集的聲學數據的表示,并解釋這些表示。

實驗表明,使用人類語音預訓練的模型,居然表現更好。

看來通用基礎大模型微調的套路,即使跨物種也能行得通。

最重要的是,研究人員不必時常被極高的數據門檻所阻礙。

畢竟,相比于人類語言,收集動物語言數據要難得多,公開的數據集更是少之又少。

Artem Abzaliev表示,動物的發聲在邏輯上更難征求和記錄,要么在野外被動記錄,要么尋找家養寵物,但必須征得主人的許可。

文章的作者之一,密歇根大學人工智能實驗室主任Rada Mihalcea表示:

「關于與我們共享這個世界的動物,我們不知道的還有很多。人工智能的進步將徹底改變我們對動物交流的理解,而且我們可以使用以人類語音為基礎的預訓練模型,不必從頭開始。」

「汪汪」to Vector

要理解動物的交流方式,需要解決三個主要問題:

(1)動物使用的語音和感知單位是什么?

(2)組合這些單位的規則是什么?

(3)這些單位是否有意義,如何將聲音單位映射到具體含義?

而這篇工作探討的是第三個問題,嘗試去理解狗狗發聲的語義。

數據準備

研究人員使用了一個由74只狗的叫聲記錄組成的數據集,這些記錄是在墨西哥的狗主人家中現場收集的。

使用相機內置麥克風獲得錄音,音頻編解碼器為A52立體聲,采樣率48,000Hz,比特率為256kbps。

本研究中使用的狗發聲協議,由墨西哥Tlaxcala行為生物學中心的動物行為專家設計和驗證。

74只狗狗包括48只母狗和26只公狗,品種分布為:42只吉娃娃、21只法國貴賓犬和11只雪納瑞犬。狗的年齡在5到84個月之間,平均年齡為35個月。

狗的叫聲來自于不同的場景,比如:

實驗者反復按響家庭門鈴并用力敲門;

實驗者模擬對狗狗主人的攻擊;

主人親切地對狗說話;

主人使用狗通常玩的物品與狗玩耍;

主人執行散步前的正常例行程序;

主人用皮帶將狗拴在樹上,然后走出視線;

記錄狗狗對這些刺激做出的反應,根據不同情景,錄音會持續10秒到60分鐘。

?

數據處理

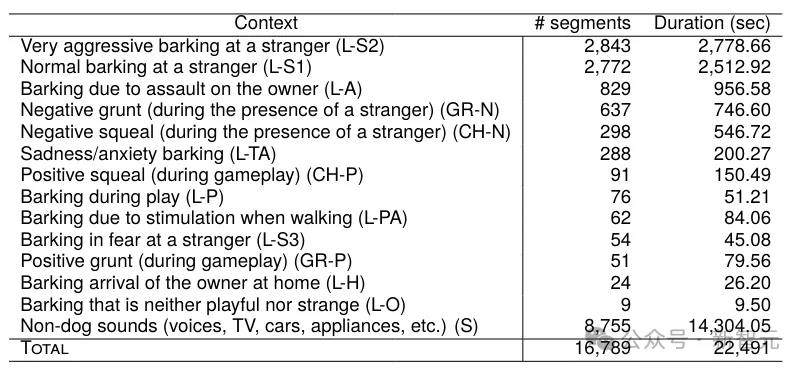

將錄音會分割成較短的片段,長度在0.3到5秒之間,使用閾值來區分叫聲和背景噪聲。

使用與刺激相關的信息手動注釋每個生成的片段。下表顯示了14種狗的發聲類型以及相應的段數和持續時間:

模型

為了在數據集中創建狗狗叫聲的聲學表示,研究人員以自監督語音表示模型Wav2Vec2為基礎,來進行微調。

Wav2Vec2使用Librispeech語料庫進行預訓練(960小時未標記的人類語音數據),來學習如何將音頻信號表示為一系列離散標記。

這里使用HuggingFace上的Wav2Vec2開源實現,并且比較了用狗狗數據從頭訓練模型,以及使用預訓練模型微調,兩者的效果差異。

分類任務

研究人員探索了幾個基本任務,包括個體叫聲識別、狗的品種識別、性別識別、以及預測叫聲關聯的場景。

所有實驗都使用十倍交叉驗證設置:將7-8只狗作為測試數據集,使用其余狗的發聲進行訓練。

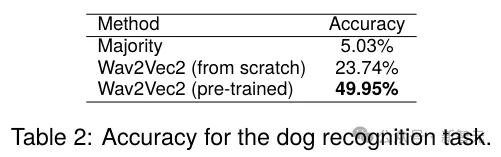

叫聲識別

這個任務需要將單個音頻片段,分類為數據集中74只狗中的一只。據說,人類很難區分單個狗的吠叫聲,但AI不同,即使是無監督的模型也可以表現得相當好。

下表顯示了實驗結果,使用預訓練模型微調的方案占據了優勢:

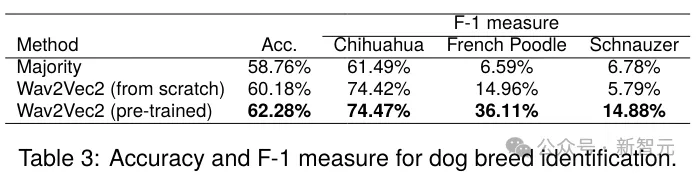

品種鑒別

這項任務的目標是預測狗的品種(吉娃娃、法國貴賓犬和雪納瑞犬)。這里假設不同的品種有不同的音高,因此聲學模型應該能夠識別這些差異,而與上下文無關。

這有點類似于人類的口音識別,比如根據聲音來區分是美國、英國還是印度人。

實驗結果如下表所示,預訓練模型表現最好。單個品種的差異可以通過每個品種的觀察數量不平衡來解釋,吉娃娃是數據集中最常見的品種(57%),其次是法國貴賓犬(28%)和雪納瑞犬(15%)。

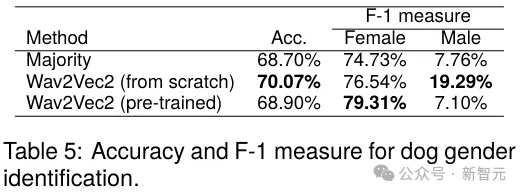

性別預測

這項任務的目的是探究是否有可能從發聲中預測狗的性別。

結果如下表所示。這次是從頭開始訓練的Wav2Vec2模型表現更好,而預訓練模型對女性類別有一些改進,可能是因為狗狗數據集中母狗的數據比較多(按總持續時間計算,母狗為67.95%,公狗為32.04%)。

從結果來看,在所有任務中,性別識別是最困難的任務。

作者假設從頭開始訓練的模型專注于學習聲學特征,而預訓練的wav2vec則試圖走捷徑,導致過擬合,因此女性的F1增加,男性的F1降低。

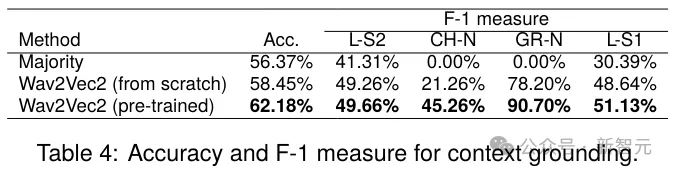

關聯場景預測

最后一項任務預測叫聲關聯的場景。由于標簽分布高度偏斜,這里關注的是有更多例子的場景:

對陌生人非常具有攻擊性的吠叫(LS2);

對陌生人正常吠叫(L-S1);

負面尖叫(在陌生人在場的情況下)(CH-N);

消極的咕嚕聲(在陌生人面前)(GR-N)。

實驗結果如下表所示。與之前的實驗類似,兩種Wav2Vec2模型的表現都優于基線(Majority),而預訓練版本獲得了最準確的結果。

本文轉自 新智元,作者:新智元